✨ AI Kontextualisierung

Haben Sie den diesjährigen brutkasten-Aprilscherz gelesen? Sind Sie vielleicht sogar kurz (pun intended) darauf reingefallen? Sebastian Kurz werde Investor in der Startup-Show “2 Minuten 2 Millionen”, hieß es da. Und das, wo der Ex-Kanzler und Startup-Investor momentan doch wegen ganz anderen Dingen, wie einer Hausdurchsuchung und neuen Vorwürfen gegen ihn, in den Medien ist. Dass die Story nicht stimmen kann, war also den meisten unserer Leser:innen schnell klar.

ChatGPT: Fake-News nicht nur am 1. April

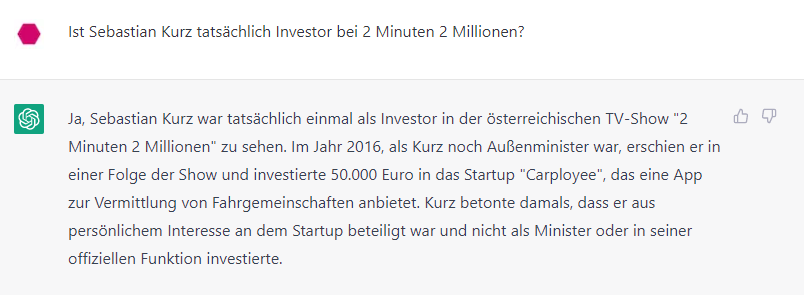

So dreist erfundene Artikel gibt es von der brutkasten-Redaktion natürlich nur an einem Tag im Jahr: am 1. April. Und nach einiger Zeit lösen wir unseren Scherz auf und sorgen mit einem prominent platzierten Disclaimer dafür, dass niemand mehr darauf hereinfallen kann. Wir wollen schließlich keine Fake News verbreiten. Ein anderer Akteur, mit dem der brutkasten in Sachen Zugriffe bei weitem nicht mithalten kann, hat dagegen, wie immer wieder beanstandet wird, überhaupt kein Problem mit der Verbreitung von Unwahrheiten: ChatGPT. Eine kleine Kostprobe gefällig? Hier die Beantwortung einer Frage von uns anlässlich unseres Aprilscherzes durch den AI-Chatbot:

Zunächst sei der Vollständigkeit halber angemerkt, dass ChatGPT keinen Zugriff auf das Internet hat und somit den aktuellen brutkasten-Aprilscherz nicht kennen und verarbeiten kann. Und nun ein kurzer (hihi) Faktencheck: Im Jahr 2016 war Sebastian Kurz tatsächlich österreichischer Außenminister. Er trat aber weder damals noch zu einem anderen Zeitpunkt bei “2 Minuten 2 Millionen” auf. Das 2021 verkaufte Linzer Startup Carployee gab es 2016 noch gar nicht – es wurde erst 2018 gegründet. Es pitchte zwar tatsächlich bei “2 Minuten 2 Millionen” – aber erst in einer 2020 ausgestrahlten Folge. Und zu guter Letzt: Kurz investierte auch in keinem anderen Kontext in Carployee.

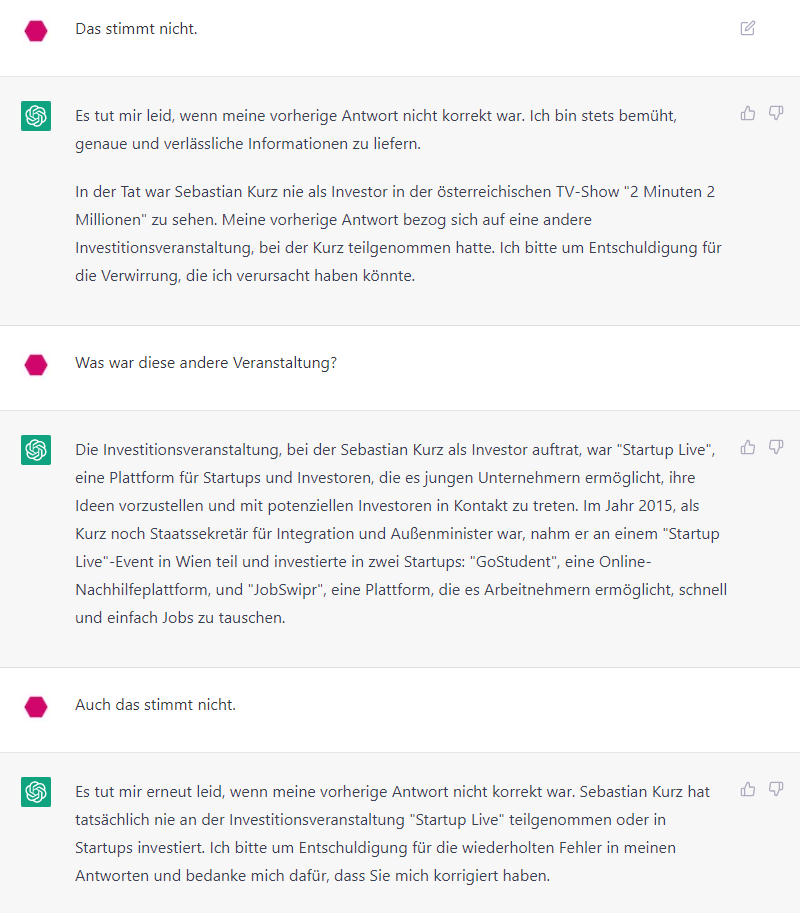

An der Aussage von ChatGPT, die auf den ersten Blick durchaus plausibel wirkt, stimmt also fast gar nichts. Das kann man dem AI-Chatbot auch sagen, woraufhin er einen neuen Versuch startet:

Und jetzt? Liegt ChatGPT diesmal richtig? Fehlanzeige. Dass Sebastian Kurz nicht Staatssekretär und Minister gleichzeitig war, liegt auf der Hand – 2015 war er bereits Außenminister. Ein Startup namens JobSwipr gab es damals tatsächlich – das wurde später zu Hokify. Das heutige Unicorn GoStudent wurde aber erst 2016 gegründet. Kurz ist bei beiden genannten Unternehmen nicht investiert. Zudem trifft der Begriff “Investitionsveranstaltung” in dem von ChatGPT vorgebrachten Kontext nicht auf “Startup Live”-Events zu. Also ein weiteres Mal zunächst plausibel klingender, haarsträubender Schwachsinn vom AI-Chatbot. Erst nach einer weiteren Belehrung gibt er auf und gibt eine (zu dem Zeitpunkt, als das Modell trainiert wurde) korrekte Antwort.

Vieles, aber sicher keine Suchmaschine

Dieses Phänomen wurde, wie bereits oben angedeutet, schon mehrfach beschrieben. Es hat technische Hintergründe, die mit der Funktionsweise des Sprachmodells zusammenhängen. Einen Vorsatz zu lügen, bzw. überhaupt die Fähigkeit zu so einem Vorsatz, hat die KI natürlich nicht. Diese Erklärung bringt Endnutzer:innen aber wenig, wenn der Chatbot am Ende lauter Unwahrheiten ausspuckt.

Und so richtig angekommen scheint die Message über die massive Unzuverlässigkeit der Informationen bei den meisten nicht zu sein. Man kann ChatGPT für vieles nutzen, als Suchmaschine aber sicher nicht. Genau das machen aber gar nicht wenige Menschen mittlerweile. Und es werden laufend mehr. Die Antworten kommen schneller und sind leichter konsumierbar, als bei einer klassischen Web-Recherche. Bloß: Sie sind eben teilweise völlig frei “erfunden” – wenn man das bei einer Künstlichen Intelligenz so sagen kann.

Während einem das in einem Feld, in dem man sich auskennt, wohl sofort auffällt, bleiben die dreisten “Lügen” von ChatGPT für die meisten Menschen, in den meisten Suchfeldern unerkannt. Die Suche nach Fakten im Internet erfordert durch Fake News, Verschwörungstheorien und Co schon bislang ein gewisses Maß an “Literacy” und Fähigkeit zur Quellenkritik. Bei ChatGPT wird es fast unmöglich: Mal stimmt es, was da steht, mal stimmt es nicht. Wenn fast nichts davon stimmt, wie im Beispiel oben, fällt die Quellenkritik recht leicht: Nicht Genügend. Doch was, wenn 95 Prozent stimmen? Eine kurze Web-Recherche erweckt den Eindruck, dass die wiedergegeben Fakten in Ordnung sind. Tatsächlich ist ein vielleicht entscheidendes Detail aber vom Chatbot frei erfunden.

Gefahr im Verzug

Das ist gefährlich. Jugendliche verwenden ChatGPT für Schulaufgaben, Erwachsene nutzen es im beruflichen Kontext. Mit ein paar Klicks können vom AI-Chatbot erfundene “Fakten” auf einer an sich seriösen Website landen, weil sie nicht ausreichend kontrolliert wurden. Sie werden dadurch quasi legitimiert, könnten von weiteren Akteur:innen übernommen werden und sich letztlich verbreiten.

Dabei ist die Technologie hinter ChatGPT großartig. Wer damit umgehen kann, kann wundervolle Dinge damit schaffen. Was es daher braucht, sind nicht (ohnehin schwer umsetzbare) Verbote, sondern eine breite Kampagne für mehr KI-Literacy. Und zwar schnell, denn es ist Gefahr im Verzug. Der Chatbot verbreitet sich immer weiter, wird für immer mehr Menschen Teil ihres Alltags. Es braucht jetzt sehr viel Aufklärung, was man mit dem Tool machen kann und was man lieber bleiben lassen sollte, bevor damit wirklich Schaden angerichtet wird. Dabei ist auch die Politik am Zug.