✨ AI Kontextualisierung

Wie bereits in Teil 1 dieses Artikels diskutiert, gibt es – abhängig vom jeweiligen Einsatz des AI-Systems – schon jetzt einiges rechtlich zu beachten. Dies insbesondere auch, um bei einem späteren Einstieg von Investor:innen und im Rahmen einer Due Diligence “Red Flags” weitestgehend zu vermeiden.

Teil 2 unseres Beitrages soll einen kurzen Blick in die Zukunft wagen, was es beim Einsatz von AI-Systemen aufgrund des Vorschlags des AI-Acts bzw. der KI-Haftungsrichtlinie zu beachten geben könnte.

1. AI Act – Back on track?

Im April 2021 veröffentlichte die Europäische Kommission einen Vorschlag für eine Verordnung über Künstliche Intelligenz (“AI Act”), der darauf abzielt, einen einheitlichen Rahmen für die Entwicklung, Einführung und Nutzung von Künstlicher Intelligenz (“KI” oder “AI”) in der Europäischen Union (EU) zu schaffen. Der AI Act befindet sich derzeit noch in einem Entwurfsstadium und wurde noch nicht endgültig verabschiedet oder in Kraft gesetzt.

Durch die Vorlage des Entwurfs machte die Kommission aber klar: Auch im Bereich der KI soll die EU ganz vorne dabei sein. Nach diesem Impuls wurde es jedoch recht schnell wieder ruhig um das Gesetzesvorhaben. Jetzt, gerade rechtzeitig mit dem Hype um ChatGPT, meldet sich der Rat mit einem gemeinsamen Standpunkt zum Kommissionsvorschlag.

Neben Lob über den generellen Ansatz des ursprünglichen Verordnungsvorschlags wurden vorwiegend kritische Stimmen über die zu weit gefasste Definition eines KI-Systems laut. Hier will der Rat nun nachbessern und den Begriff enger und konkreter bestimmen, indem nur noch Systeme erfasst sind, die auf Konzepten des maschinellen Lernens sowie logik- und wissensgestützten Konzepten basieren. So soll eine Überregulierung von klassischen Softwaresystemen verhindert werden.

2. AI Act – Ein Überblick über den “risk-based approach”

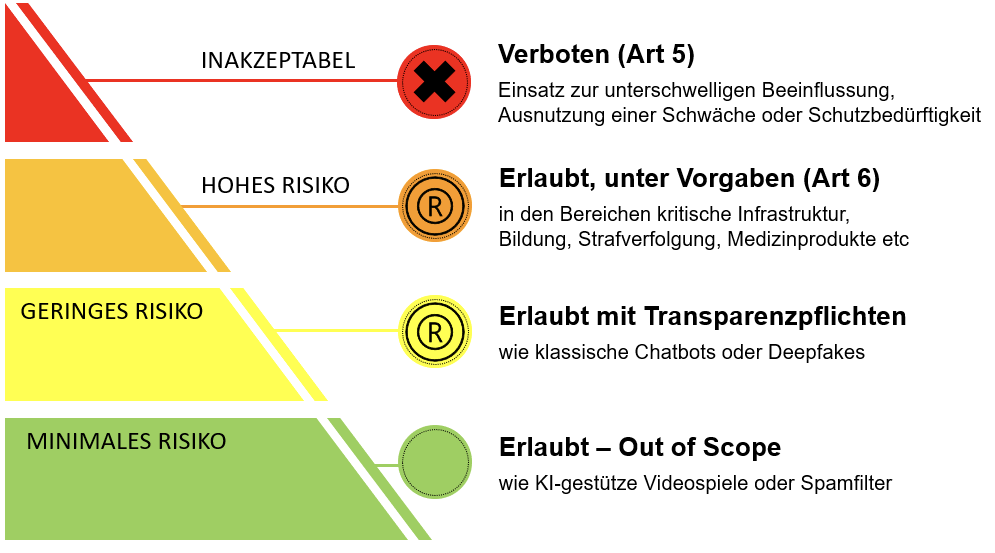

Sowohl der Vorschlag der Europäischen Kommission als auch die Stellungnahme des Rates folgen einem “risk-based approach”. Der AI Act teilt KI-Systeme in verschiedene Risikokategorien (von inakzeptablem Risiko bis hin zu geringem Risiko) ein und erlegt den Verantwortlichen – abhängig von der jeweiligen Einteilung eines KI-Systems – Handlungspflichten auf. Die folgende Grafik zeigt die vorgeschlagene Einteilung von AI-Systemen anhand des damit verbundenen Risikos.

Ganz oben in der Risikopyramide stehen KI-Systeme, die eine Bedrohung für Menschen, Sicherheit und Grundrechte darstellen (können). Solche Anwendungsfälle können etwa KI-Systeme zur unterschwelligen Manipulation oder biometrischen Identifizierung zur Strafverfolgung an öffentlichen Orten sein. Bis auf wenige Ausnahmen ist der Einsatz derartiger KI-Systeme unter dem vorgeschlagenen Regelwerk generell verboten. Nach dem Vorschlag der Europäischen Kommission soll (nur) das Social Scoring durch den öffentlichen Sektor unter “inakzeptables Risiko” fallen. Der Rat möchte dieses Verbot erweitern und schlägt vor, das Verbot auch auf den privaten Bereich auszuweiten.

High-Risk Systeme, wie unter anderem KI-Technologien, die in der medizinischen Diagnose und Behandlung eingesetzt werden, sind zwar nicht verboten, stehen aber unter strengen Anforderungen für die Entwicklung, das Inverkehrbringen sowie die Nutzung. Diese müssen einem behördlichen Konformitätsbewertungsverfahren standhalten, bei dem die Einhaltung der unter der Verordnung notwendigen Vorkehrungen überprüft wird. Dazu zählen etwa ein Risikomanagement, die menschliche Aufsicht über das System sowie die Cybersicherheit.

Mit KI-Systemen in Chatbots und Deepfakes assoziiert der AI Act lediglich ein geringes Risiko. Der europäische Gesetzgeber bleibt hier weiter bei hauptsächlich oberflächlichen Maßnahmen und sieht eine Kennzeichnung des Systems als ausreichend an.

Die Nutzung von KI-Technologieanwendungen mit minimalem Risiko wird durch den AI Act nicht berührt. Darunter fallen KI-gestützte Videospiele oder auch Spam-Filter.

Die tatsächliche Einstufung eines KI-Systems kann aufwendig und komplex werden, ihr solltet euch daher absichern und für die Beurteilung Expert:innen hinzuziehen. Je nachdem, wann euer AI-System auf den Markt gebracht wird bzw wie lange es verkauft werden soll, kann eine frühzeitige (freiwillige) Berücksichtigung des AI Acts bereits sinnvoll sein.

3. Worauf ist als Startup nun zu achten?

Zwar steht der AI Act noch nicht vor der Tür, sondern taucht wohl eher erst am Horizont auf, dennoch sollten ambitionierte Startup-Gründer:innen bereits jetzt einige Anforderungen im Hinterkopf behalten.

Regulierung wird einerseits oft als Innovationstreiber bezeichnet. Umfassende Regulierung sowie aufwendige Registrierungs- und Prüfungsverfahren können jedoch insbesondere Startups und KMUs den Markteinstieg erschweren. Dieses Phänomen ist bisher insbesondere auf dem Finanzmarkt bekannt. Viele der zukunftsorientierten KI-Anwendungen fallen in die selbstdefinierte “High-Risk”-Kategorie des AI Acts. Der Fokus des Verordnungsvorschlags liegt klar auf der Regulierung solcher High-Risk-Systeme. Die für ein Inverkehrbringen und eine Inbetriebnahme notwendige Konformitätsbewertung durch Dritte wird nur durch intensive rechtliche und technische Vorbereitung von Seiten der KI-Anbieter:innen möglich sein. Bei selbstlernenden KI-Systemen ist eine solche Bewertung sogar auf laufender Basis durchzuführen, was für eine zusätzliche Belastung sorgt.

Der Standpunkt des Rates versucht ein Ausarten der High-Risk-Kategorie durch eine zusätzliche Anknüpfung an lediglich schwerwiegende Grundrechtsverletzungen oder andere bedeutende Risiken zu verhindern. Darüber hinaus sollen auch Vereinfachungen bei den Verfahren und technischen Anforderungen KMUs und Startups begünstigen.

Wie diese geplanten Erleichterungen tatsächlich aussehen werden, ist kaum abzuschätzen. Ihr solltet bereits jetzt ausreichend Ressourcen und Zeit für zusätzliche Prüfungen und Prozesse einplanen.

4. Ausblick auf die KI-Haftungsrichtlinie

Um noch einmal auf den aktuellen Hype zurückzukommen: Was passiert nun, wenn ein Chatbot eine wesentliche Falschauskunft liefert und so tatsächlich einen Schaden verursacht? Wenn ein KI-System voreingenommen agiert und damit Personengruppen von Vornherein von einem Bewerbungsprozess ausschließt oder Menschen durch den Einsatz von intelligenten Operationsrobotern sonst zu Schaden kommen?

Ein dramatisches Beispiel für eine potenzielle Schädigung durch künstliche Intelligenz war der Testlauf eines medizinischen Chatbots, der ebenfalls auf GPT-3-Software basierte. Zum einen reagierte die KI mit eigenartigen medizinischen Diagnosen, viel drastischer aber war, dass der Bot in psychologischen Gesprächen die Patient:innen dazu ermunterte, sich ihren Suizidgedanken hinzugeben. Durch den AI Act sollen je nach Risikoeinstufung des KI-Systems Vorkehrungen getroffen werden, um solche Fehler möglichst zu vermeiden (siehe dazu bereits oben).

Falls durch ein KI-System aber trotzdem ein Schaden verursacht wird, müssen entsprechende gesetzliche Grundlagen für eine Haftung bereitgestellt werden. Während die Nachweisbarkeit eines Schadens selten ein Problem darstellt, scheitert der Beweis der Kausalität und Schuld bereits merkbar öfter. Angefangen bei Chatbots wird der Nachweis von Kausalität und Verschulden bei hoch-komplexen KI-Systemen wohl ungemein schwerer.

Die europäische Kommission hat dieses Risiko bereits erkannt und reagierte im September mit einem Richtlinienvorschlag über die KI-Haftung. Die im englischen AI Liability Directive genannte Richtline soll den AI Act um ein wirksames zivilrechtliches außervertragliches und verschuldensabhängiges Haftungssystem, insbesondere für High-Risk-KI-Systeme, ergänzen. Die Durchsetzbarkeit von Haftungsfällen wird durch ein Zusammenspiel von Vermutungsregeln und Offenlegungspflichten erleichtert. Ziel ist es, dadurch insbesondere den Black-Box-Effekt zu überwinden, da die menschliche Handlung oft nicht mehr problemlos mit einem Ereignis in Verbindung gebracht werden kann, wenn ein “selbstständiges” KI-System dazwischentritt.

Gerichte sollen daher widerlegbar Verschulden vermuten können, wenn eine gerichtlich aufgetragene Offenlegungspflicht nicht erfüllt wird. Ist das Verschulden nachgewiesen oder zumindest vermutet worden, kann das Gericht auch eine widerlegbare Kausalitätsvermutung anstellen. Da aber eine solche Vermutung auch für eine:n Schädiger:in oft schwer zu widerlegen sein kann, stellt die Richtline bestimmte Anforderungen und Einschränkungen auf.

So muss es nach den Umständen des Falles als hinreichend wahrscheinlich angesehen werden können, dass das Verschulden das Ergebnis des KI-Systems beeinflusst hat und das Verschulden selbst auf einem Verstoß gegen ein Gesetz beruht, das gerade solche Schäden verhindern soll. Zusätzlich wird die Zulässigkeit einer Vermutung für KI-Systeme mit einem geringen Risiko deutlich eingegrenzt und ist auch für High-Risk Systeme ausgeschlossen, wenn ohnehin ausreichend Beweismittel vorliegen.

Für den potenziellen Schädiger wird es zum großen Nachteil, wenn keine entsprechenden Aufzeichnungen offengelegt werden können. Beim Einsatz von KI-Systemen solltet ihr euch bereits davor um rechtskonforme Unterlagen und Aufzeichnungen kümmern.

5. Haftung vor Umsetzung der KI-Haftungsrichtlinie (k)ein Thema?

Bis man sich auf EU-Ebene über die KI-Haftungsrichtlinie geeinigt hat bzw bis diese dann tatsächlich in den nationalen Mitgliedstaaten umgesetzt wird, wird noch einige Zeit vergehen. Dennoch sollten Unternehmen das Thema Haftung schon jetzt beachten.

Einerseits kann der Einsatz von KI-Systemen oder sonstiger Software auch bereits nach geltendem Recht zur Haftung von Anwender:innen führen (beispielsweise wenn KI-Systeme durch eine:n Mitarbeitende:n eines Unternehmens falsch bedient werden). Andererseits können, insbesondere im B2B Kontext, auch vertragsrechtliche Regelungen haftungsbegründend wirken (z.B. kann ein Vertrag vorsehen, dass eine Software eine bestimmte Verfügbarkeitszeit aufweist, eine bestimmte Fehlerrate nicht überschreitet oder Ähnliches).

Wenn ihr Software lizensiert, Software as a Service anbietet oÄ, solltet ihr zu Beginn Zeit in ein ausreichendes Vertragstemplate investieren, um sicherzustellen, dass keine “versteckten” Haftungen enthalten sind.

6. Zusammenfassung

Bei der folgenden kurzen Zusammenfassung hat uns wieder ChatGPT unterstützt. Es gilt aber weiterhin: Wer auf aber auf Nummer sicher gehen und nichts verpassen will, sollte Texte trotzdem noch selbst lesen.

Der AI Act ist ein Gesetzentwurf der Europäischen Kommission, der sich darauf konzentriert, einen einheitlichen Rahmen für die Entwicklung, Einführung und Nutzung von Künstlicher Intelligenz in der EU zu schaffen. Der AI Act unterteilt AI-Systeme in Risikokategorien und legt für jede Kategorie Handlungspflichten fest. Die High-Risk-Systeme, wie KI-Technologie, die in der medizinischen Diagnose und Behandlung eingesetzt werden, sind den strengeren Anforderungen unterworfen und müssen einem behördlichen Konformitätsbewertungsverfahren standhalten. Die Low-Risk-Systeme haben weniger strenge Anforderungen und müssen keinem behördlichen Verfahren unterzogen werden, aber sie müssen dennoch Risiken minimieren und eine geeignete Dokumentation aufbewahren. Die KI-Haftungsrichtlinie hingegen zielt darauf ab, den Schadenersatz für Schäden, die durch KI-Systeme verursacht werden, zu regeln und sicherzustellen, dass die Verantwortlichen für KI-Systeme haftbar gemacht werden können.

Über die Autor:innen

Dr. Martin Hanzl ist Rechtsanwalt und Head of New Technologies bei EY Law Pelzmann Gall Größ Rechtsanwälte GmbH. Er betreut nationale und internationale Kryptodienstleister, FinTechs, Start-Ups sowie Finanz- und Versicherungsinstitute, insbesondere zum Einsatz von New Technologies, komplexen regulatorischen Fragestellungen und bei gesellschaftsrechtlichen Fragestellungen rundum Finanzierungsrunden und Exits. Überdies ist er Projektverantwortlicher des „Blockchain and Smart Contracts“-Projektes des European Law Institutes. Er ist Vortragender an der Anwaltsakademie, Fachhochschulen und Universitäten sowie Herausgeber und Autor mehrerer Handbücher sowie zahlreicher weiterer Fachartikel zu den Themen Digitalisierung, Smart Contracts, New Technologies und Gesellschaftsrecht.

Mag. Alexander Glaser ist Rechtsanwaltanwärter bei EY Law Pelzmann Gall Größ Rechtsanwälte GmbH mit dem Fokus auf IP/IT Recht sowie neue Technologien und betreut Mandant:innen insbesondere zu Fragen rund um Krypto-Assets (zB rechtliche Einordnung, Registrierung als CASP) sowie Schutz und Nutzung von IP (ua KI-Systeme, Softwarelizensierung).

Elisabeth Kutner LL.B. (WU) ist Masterstudentin des Studiengangs Wirtschaftsrecht der Wirtschaftsuniversität Wien und juristische Mitarbeiterin bei EY Law Pelzmann Gall Größ Rechtsanwälte GmbH mit dem Fokus auf IP/IT Recht und neue Technologien.

Disclaimer: Die finalen Texte des AI Acts und der AI Liability Directive liegen zum Zeitpunkt dieses Beitrages noch nicht vor und können daher von der gegenständlichen Darstellung abweichen. Dieser Text gibt lediglich einen Überblick über ausgewählte Fragestellungen im AI-Kontext und hat weder den Anspruch auf Vollständigkeit noch stellen die Hinweise und Informationen Rechtsberatung oder sonstige Empfehlungen dar. Dieser Text kann keinesfalls eine individuelle Rechtsberatung ersetzen und dient lediglich der persönlichen Information. Dieser Text gibt überdies ausschließlich die Meinungen und Erfahrungen der Autor:innen wieder.