✨ AI Kontextualisierung

Wie das “New England Journal of Medicine” berichtete, haben kalifornische Forscher ein Gehirnimplantat (Neuroprothese) entwickelt, das Signale des Hirns in Worte auf einem Computerbildschirm übersetzt. Damit eröffnet sich die Möglichkeit Menschen zu helfen, die die Fähigkeit zu sprechen aufgrund von Krankheiten oder Verletzungen verloren haben.

“Wir haben ein subdurales, hochdichtes Multielektroden-Array über dem Bereich des sensomotorischen Kortex implantiert, der die Sprache bei einer Person mit Anarthrie (Anm: Verlust der Fähigkeit, Sprache zu artikulieren) aufgrund eines Hirnstamm-Schlaganfalls kontrolliert”, beschreibt das Forscherteam in ihrem veröffentlichten Artikel. “Im Verlauf von 48 Sitzungen zeichneten wir 22 Stunden kortikale Aktivität auf, während der Teilnehmer versuchte, einzelne Wörter aus einem Vokabular von 50 Wörtern auszusprechen.”

Sätze mittels Wahrscheinlichkeit dekodieren

Dabei wurden Deep-Learning-Algorithmen verwendet, um Computermodelle für die Erkennung und Klassifizierung von Wörtern anhand von Mustern in der aufgezeichneten kortikalen Aktivität zu erstellen. “Wir wendeten diese Computermodelle sowie ein natürliches Sprachmodell an, das Wahrscheinlichkeiten für das nächste Wort aus den vorangegangenen Wörtern einer Sequenz ermittelt, um ganze Sätze zu dekodieren, während der Teilnehmer versucht, sie zu sagen”, so die Forscher weiter.

Um das Ganze zu testen, holten sich die Forscher der “University of California” in San Francisco, die Hilfe eines Mannes in den Dreißigern, der durch einen schweren Schlaganfall 15 Jahre zuvor die Fähigkeit zu sprechen verloren hatte. Ihm wurde ein kleines rechteckiges Feld von Elektroden chirurgisch an der äußeren Oberfläche seines Gehirns angebracht.

UCSF-Video über die Neuroprothese

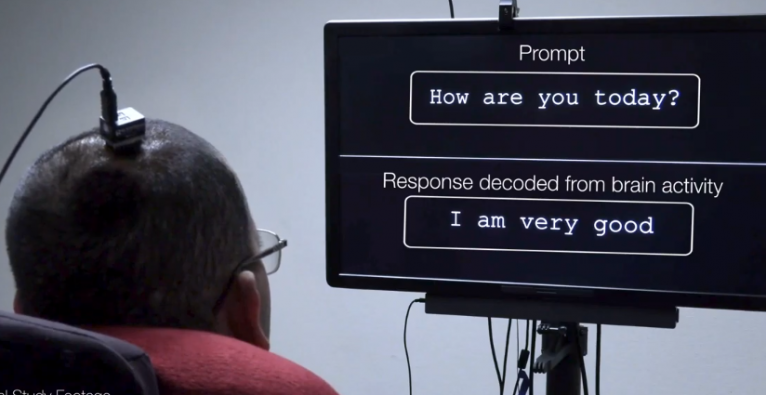

Im Laufe von 81 Wochen schlossen die Forscher einen Computer an das Array an, um die Gehirnaktivität des Mannes aufzuzeichnen, während er einzelne Wörter auf einem Bildschirm sah und sich vorstellte, sie laut auszusprechen. Anfangs konnten in 47 Prozent der Fälle die Worte genau identifiziert werden. Als die Wissenschaftler später Algorithmen zur Wortvorhersage einsetzten, die der “Auto-Suggest”-Funktion von E-Mail- und Textverarbeitungsprogrammen ähneln, stieg die Genauigkeit auf 76 Prozent.

Erste Worte aus Hirnaktivität

Die Technologie steht noch am Anfang – der Wortschatz eines Kindes in der Volksschule besteht aus mehreren Tausend Worten – stellt aber dennoch einen Durchbruch dar. “Unseres Wissens ist dies die erste erfolgreiche Demonstration der direkten Dekodierung ganzer Wörter aus der Hirnaktivität einer Person, die gelähmt ist und nicht sprechen kann”, sagte etwa Eddie Chang, Neurochirurg an der Universität und leitender Autor der Arbeit. “Es ist vielversprechend, die Kommunikation wiederherzustellen, indem man die natürliche Sprachmaschinerie des Gehirns anzapft.”

Gesponsert wird die Forschungsarbeit mitunter von Facebook. Das Unternehmen setzt seine Hoffnungen auf die Entwicklung eines nicht-invasiven, tragbaren Geräts, das Personen das Tippen durch Denken ermöglichen soll.

Mark Zuckerberg dazu: “Interessanter Meilenstein des Brain-Computer-Interface-Teams, das Facebook an der UCSF unterstützt hat: Ein Forschungsteilnehmer mit schwerem Sprachverlust war in der Lage, über eine Schnittstelle zu kommunizieren, die erkennt, was er zu sagen versucht, indem sie Gehirnsignale dekodiert, die von seinem motorischen Kortex an seinen Vokaltrakt gesendet werden. So etwas ist noch nie zuvor gemacht worden, und es ist großartig zu sehen, wie verschiedene neurowissenschaftliche Ansätze für Schnittstellen große Schritte nach vorne machen (ebenso wie unsere Arbeit, die Signale zu verstehen, die das Gehirn an die motorischen Neuronen in unseren Handgelenken sendet). Herzlichen Glückwunsch an das UCSF-Team zu diesem Fortschritt!”