✨ AI Kontextualisierung

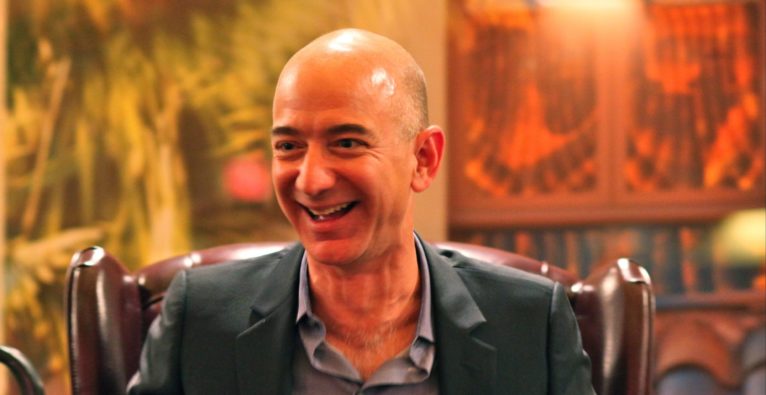

Jeff Bezos ist eine Persönlichkeit an der heutzutage niemand vorbeikommt. Der Amazon-Gründer ist regelmäßig in den Medien. Sei es weil seine „Nemesis“ Elon Musk immer wieder mit Angriffen gegen den Online-Händler auffällt, der fragwürdige Umgang seiner Mitarbeiter sich medial verbreitet, sein Vermögen wiederholt geschätzt wird, der Streaming-Dienst in aller Munde ist oder wenn Bezos den Philanthropen hervorholt und große Summen für den guten Zweck spendet. Weitaus seltener liest man von einer weiteren Leidenschaft des Milliardärs, die er bereits seit zwei Jahrzehnten ausübt: von der Space-Company Blue Origin.

+++ Wr. Neustädter Space-Startup Tumbleweed: Von der Garage bis zum Mars +++

Während SpaceX die letzten Wochen die Zukunft der Raumfahrt veränderte und die erste von einem Privatunternehmen gebaute und bemannte Raumfähre seit 39 Jahren (Space Shuttle) ins All sandte – oder damit wirbt, dass man Touristen mittels „ridesharing“ ab einer Million Dollar ins Weltall bringt, hört man von Bezos Space-Company, die Teil von Bezos Expeditions ist, relativ wenig.

Blue Origin: Zwei Dekaden alt

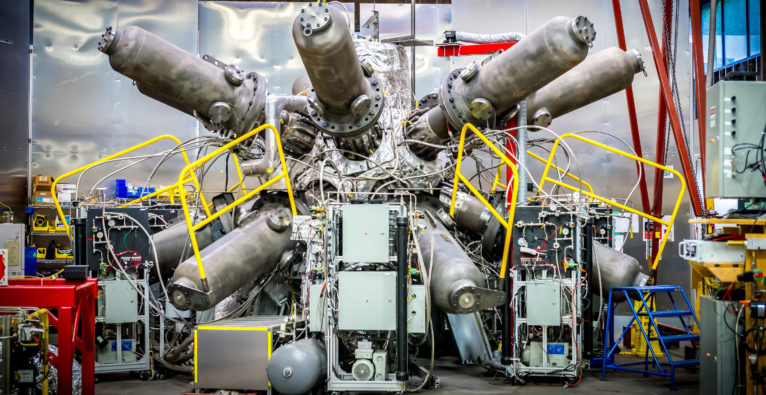

Und das, obwohl Blue Origin für den Weltraumtourismus erschaffen wurde. Es war der September vor rund 20 Jahren, als das US-Unternehmen seine ersten Schritte tat und Raketenantriebssysteme und Trägerraketen entwickelte. Mit dem Motto „step by step“ ließ man sich drei Jahre Zeit, bis Bezos die Existenz der Firma öffentlich machte. Zehn Jahre später hatte der Amazon-Gründer eine halbe Milliarde US-Dollar in das Unternehmen gesteckt und schlussendlich 2015 den ersten Testflug seines vertikalen Raumgefährts „New Shepard“ vollbracht.

„Verkauf von Amazon-Aktien“ für Blue Origin

Die Rakete erreichte damals eine Geschwindigkeit von Mach 3, wurde bis heute mehrere Male erfolgreich getestet und hat mit „New Glenn“ (nach dem ersten US-Astronauten John Glenn benannt) bereits einen Nachfolger, der „Payloads“ und Personen ins All befördern soll. Seit 2016 arbeitet Blue Origin mit einem Budget von einer Milliarde US-Dollar jährlich, die Bezos mit dem Verkauf von Amazon-Aktien finanziert. Das war auch das Jahr, in dem sich das Unternehmen zum ersten Mal der Öffentlichkeit öffnete und die Produktionsstätte in Kent, Washington, für Journalisten zugänglich machte.

Video: Start und Landung der New Shepard im Jahr 2015

Jeff Bezos: Plan B für die Welt

Damals sagte Bezos, dass der Weltraum voller Ressourcen sei und dass die Erde einen „Plan B“ brauche, wenn etwas Schlimmes passiert. Und führte fort: „Es wird einfach ein unglaublich lustiger und inspirierender Teil der Zukunft der Menschheit sein, das Sonnensystem zu erforschen“.

Ein Jahr später vermeldete Bezos, dass Blue Origin den ersten zahlenden Kunden für Orbital-Satelliten an der Hand habe. Eutelsat wird voraussichtlich 2022 mit dem Start von TV-Satelliten auf den „New Glenn Orbital-Trägerraketen“ beginnen. Mittlerweile gesellten sich auch OneWeb und Mu Space als Kunden dazu.

Buhlen um NASA

Heute kämpft Blue Origin mit Space X und Dynetics um einen NASA-Ausftrag. Die US-Behörde möchte mit ihrem Artemis-Projekt 2024 Menschen auf den Mond schicken (darunter eine Frau) und hat einen Contest unter den drei Unternehmen ausgerufen. Die konkurrierenden Firmen sollen jeweils einen Entwurf für einen „Mondlander“ vorlegen und werden dabei auch finanziell unterstützt: Blue Origin bekommt 579 Millionen US-Dollar, SpaceX 135 Millionen und Dynetics 253 Millionen.

„Mit diesen Auftragsvergaben treibt Amerika den letzten Schritt voran, der erforderlich ist, um Astronauten bis 2024 auf dem Mond zu landen, einschließlich des unglaublichen Moments, in dem die erste Frau die Mondoberfläche betreten wird“, sagt NASA-Administrator Jim Bridenstine.

Blue Origin arbeitet dafür an einem dreistufigen Lander, der seine Motoren auf der Mondoberfläche abstellt, um die Last zu erleichtern, wenn es Zeit ist, zur Erde zurückzukehren. SpaceX möchte dagegen sein Allzweck-Raumschiff „Starship“ verwenden, das angeblich auch für Mars-Missionen verwendet werden kann. Dynetics plant einen innovativen Lander, der mit jeder Rakete gestartet werden kann.

Kostensenkung durch Wiederverwertung

Bei allen drei Anbietern steht Kostensenkung im Vordergrund. Diese soll mit der Wiederverwertung von wichtigen Teilen der Trägerrakete und mit weniger Gewicht geschehen. Während der Transport von einem Pfund Materie (450 Gramm) in der Spaceshuttle-Ära knappe 25.000 US-Dollar kostete, so sind es heutzutage etwas mehr als 1200 US-Dollar, wie die NZZ berichtet.

Suborbitale Raumfahrt

Wie auch immer diese Ausschreibung ausgeht, Blue Origin CEO Bob Smith hat 2020 zu einem „arbeitsreichen Jahr“ erklärt. Axios zitierte den Geschäftsführer noch im Mai mit den Worten, dass es „drei oder mehr Flüge geben wird, bevor wir Leute fliegen“. Smith sagte zudem, der aktuelle Plan sei es, das noch heuer zu schaffen. Der Preis für einen Fluggast ist noch nicht offiziell verkündet worden, kann aber für die suborbitale Raumfahrt mit mehreren Hunderdtausend US-Dollar kalkuliert werden.

Tot, wenn Erfolg da

Wie erwähnt: Bezos verkauft seit drei Jahren immer wieder Amazon-Anteile, um Blue Origin finanziell zu fördern. Er sagte einst sinngemäß, er werde wohl tot sein, wenn die Früchte seiner Arbeit geerntet werden. Ein äußerst bemerkenswerter Satz, bringt man ihn mit einem schmeichelhaften Portrait der Plattform Medium in Verbindung.

Kritik am Amazon-Gründer

Man darf bei der Lobpreisung des Amazon-Gründers als Visionär nicht vergessen, dass der Milliardär regelmäßig unter starker Kritik steht. Amazons ökologischer Abdruck betrug 2018 44 Millionen Tonnen CO2. Daher hat der „reichste Mann der Welt“ im Frühjahr den „Bezos Earth Fund“ erschaffen und angekündigt, zehn Milliarden US-Dollar darin zu investieren. Allerdings ohne genau zu präzisieren wohin die Summe fließen soll.

Zudem wurden nach dieser Ankündigung kritische Stimmen der eigenen Mitarbeiter laut. Unter der Vereinigung namens „Amazon Employees for Climate Justice“ loben die Kritiker die Humanität von Bezos, fragen aber auch zugleich: „Wann wird Amazon aufhören, Öl- und Gasunternehmen dabei zu helfen, die Erde mit noch mehr Öl- und Gasbohrungen zu verwüsten? Wann wird Amazon die Verantwortung für die Lungen von Kindern in der Nähe seiner Logistikzentren übernehmen, indem man von Diesel- auf vollelektrische Lastwagen umsteigt?“.

Druck auf Amazon-Mitarbeiter

Andere Kritikpunkte umfassen den Umgang mit Lieferanten und Mitarbeitern während der Corona-Krise. Wie es auch die Washington Post schreibt, als zwei Angestellte nach kritischen Äußerungen zur Sicherheit im Job gefeuert wurden. Bereits vorher hatte die New York Post in einem Gespräch mit der ehemaligen Mitarbeiterin Maureen Donnelly aufgedeckt, welchen Verboten man als Amazon-Arbeiter unterliegt. Keine Getränke, außer Flaschen mit Wasser, keine Handys (was für Eltern ein Problem darstellt, da sie keine Notfallnummern an Schulen und dergleichen weitergeben konnten), Druck bei zu vielen Klopausen, 12-Stunden-Schichten, ohne die Möglichkeit der Konversation mit Kollegen.

Vierdimensionaler Blick auf die Zeit

Dies ist eine Seite des Amazon-Herrschers. Die andere Seite – und eher mit einem unternehmerischen Auge angeblickt – ist jene, die Mitte Mai der Autor Michael Simmons auf medium.com entwarf. Auf der Plattform wird behauptet, dass Menschen eines Schlags von Jeff Bezos „Zeit in 4D sehen“, der Rest der Menschheit sie „nur“ eindimensional wahrnimmt. Während die meisten CEOs generell Tage, Wochen oder Monate im Voraus denken, planen Visionäre in Dekaden oder sogar Jahrhunderten, heißt es.

Hohe „failure-Chance“

Nicht bloß das: Menschen wie Bezos stecken ihr Kapital in ihre Ideen hinein, die eine hohe „failure“-Wahrscheinlichkeit haben und dessen Ausgang sie gar nicht miterleben werden. Passend dazu Bezos Aussage: „Ich glaube an einen langen Zeitraum – ich denke dabei an ein paar Hundert Jahre. Ich bin von Jahr zu Jahr überzeugter, dass Blue Origin, die wichtigste Arbeit ist, die ich tue“.

Dieses Zitat, so Medium weiter, übe eine Faszination aus, da Bezos Steckenpferd, Amazon, zu einem der größten Unternehmen der Welt gehört; und weil Blue Origin – auch im Vergleich zu SpaceX – relativ unbekannt ist. Hier soll der US-Amerikaner seine weitsichtige Denkweise, um nicht zu sagen sein „future-mindset“ offenbaren, wenn er sagt: „Ich arbeite daran, weil, wenn wir es nicht tun, enden wir mit einer Zivilisation in Stasis“.

Eine Billion Menschen ins All

Damit spielt er auf die „baldige“ Energiekrise an, die der Welt bevorsteht und appelliert daran, die gesamte Erdoberfläche mit Solarzellen zu bedecken. Dieses „soon“ der Energiekrise beziffert Bezos mit ein paar Hundert Jahren, in denen der Mensch Lösungen für gesteigerte Bedürfnisse finden muss. Denn, wie er sagt: „Nehmen wir das Szenario, in dem wir ins Sonnensystem ziehen. Das Sonnensystem kann leicht eine Billion Menschen vertragen. Und wenn wir eine Billion Menschen hätten, hätten wir tausend Einsteins und tausend Mozarts und unbegrenzte Ressourcen und Solarenergie.“

Bezos plant ein Quartal drei Jahre voraus

Der weitere Text umschreibt, warum Bezos bereit ist Milliarden US-Dollar zu riskieren, bei Projekten dessen ROI Jahre in der Zukunft liegt. Und wie sein long-term-thinking Amazon geschärft hat. Angeblich arbeitet der Gründer – im Gegensatz zu anderen CEOs – nicht am nächsten Quartel, sondern an einem Zeitraum weiter in der Zukunft: „Wenn mir Freunde nach einer vierteljährlichen Gewinnmitteilung gratulieren, sage ich ‚danke‘, aber dieses Quartal wurde vor drei Jahren gebacken‘. Ich arbeite jetzt an einem Quartal, das im Jahr 2021 stattfinden wird“.

Amazon nur Mittel zum Zweck?

Jeff Bezos wurde als Vieles bezeichnet: Philanthrop, Visionär, gieriger Turbokapitalist. Oft wundern sich Beobachter und Kritiker, warum der „reichste Mensch der Welt“ mit einem der erfolgreichsten Unternehmen der Weltgeschichte Logistikmitarbeiter nicht ausreichend entlohnt, warum er sie ausbeutet und gefährdet. Oder bei Kritik an Arbeitsbedingungen mit Diszplinierungsmaßnahmen droht. Eine Erklärung dafür findet sich vielleicht bei einem Querblick und mündet in einer einzigen Schlussfolgerung: Jeff Bezos ist Amazon egal.

+++ Elon Musk wollte Tesla-Fabrik trotz Lockdown-Verordnung wieder öffnen +++

Vielleicht nicht unbedingt egal, aber scheinbar ist der Online-Shopping-Riese für den Milliardär bloß ein Mittel zum Zweck. Jeff Bezos ist ein „Nerd“. Er steckt unglaublich viel Geld in TV-Fantasy-Produktionen wie „Wheel of Time“ (Das Rad der Zeit) oder einen „Lord of the Rings“-Ableger und gilt als Fan fiktionaler Literatur. Dazu gehört nicht bloß die visuelle Erschaffung mittelalterlicher Gesellschaften mit Magie und Schwert fürs TV, sondern auch der Blick nach oben.

Das Wie ist nicht wichtig?

Wenn Bezos wirklich das 4D-Mindset hat und wie er selbst sagt Blue Origin sein eigentliches Vermächtnis an seine Enkel, Urenkel und der Welt sein soll, dann erweist sich Amazon wohl nur als „Cash-Cow“ für eine größere Sache: Der Eroberung des Alls. In diesem Sinne zählen zweifelhafte Praktiken hinsichtlich Behandlung der Mitarbeiter nicht, die Gefährdung von Leben in einer Pandemie ist nur ein Nebenaspekt ausgerichtet auf ein Ziel, schlechte Entlohnung und Leiharbeiterschaft reihen sich da ebenso mit ein, wie ökologische und weitere Kritikpunkte am Konzern.

„Amazon wird sterben“ – Blue Origin überdauern

„Amazon wird sterben“ hatte Bezos im Laufe der letzten Jahre prophezeit. 2014 sprach er von nur ein paar Dekaden, die große Firmen überstehen, 2017 adressierte er seine Shareholder und sprach von einem schmerzlichen Niedergang und 2018 sagte er laut CNBC „Amazon ist nicht ‚too big to fail‘. Ich kann euch sogar versprechen, dass Amazon eines Tages scheitern wird.“

Bevor das Unternehmen untergeht, wird Bezos es (und alle Beteiligten) solange „ausschlachten“, wie es braucht, um Blue Origin immer wieder und stetig mit Kapital zu versorgen, um die Raumfahrt zu zähmen wie früher Pferde. Und dafür arbeiten, dass seine große Liebe ihn lange überdauert, wenn die Grenzen der Erde längst durchbrochen und er selbst von uns gegangen ist.