✨ AI Kontextualisierung

Traditionell erwirtschaften Waldbesitzer:innen ihre Einnahmen primär durch Holznutzung. Gleichzeitig erbringt der Wald jedoch weitere wertvolle Ökosystemleistungen für die Gesellschaft, die das Vorarlberger Startup Tree.ly rund um Gründer Jodok Batlogg in Form von CO2-Zertifikaten zugänglich machen möchte.

Über die gleichnamige Plattform Tree.ly können Waldbesitzer:innen berechnen, wie viel CO2 ihr Wald speichert und wie die CO2-Aufnahme des Waldes verbessert werden kann. Zudem bietet das Unternehmen in einem weiteren Schritt auch eine CO2-Zertifzierung an, um im Anschluss CO2-Zertifkate am Markt verkaufen zu können. Unternehmen und Privatpersonen können wiederum CO2-Gutschriften aus regionalen Wäldern erwerben und somit einen direkten Klimaschutzbeitrag in ihrer Region leisten. – der brutkasten berichtete über das Konzept.

Tree.ly erreicht “Meilenstein”

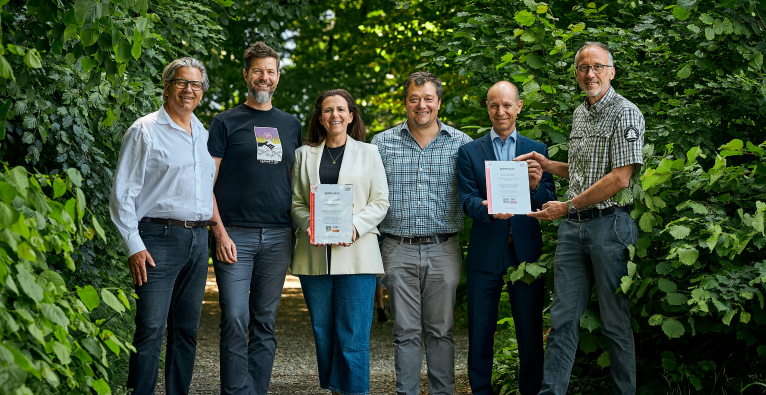

Wie das Unternehmen am Mittwoch bekannt gab, wurde nun ein “wichtiger Meilenstein” erreicht “Die ersten österreichischen Waldprojekte wurden vom TÜV validiert und verifiziert”, so Batlogg gegenüber dem brutkasten. Zudem wurden bereits die ersten TÜV Austria-zertifizierten CO2-Gutschriften übergeben.

Dazu heißt es in einer Aussendung: “Bereits 21 Vorarlberger Städte und Gemeinden sichern sich nach erfolgreicher ISO-Zertifizierung durch den unabhängigen TÜV Austria die ersten regionalen CO2-Gutschriften.” Zu den Partner:innen zählen der Stand Montafon Forstfonds, Forstbetriebsgemeinschaft Klostertal und Jagdberg, die Städte Bludenz und Dornbirn sowie weitere Gemeinden. Gemeinsam bewirtschaften sie eine Waldfläche von knapp 13.000 Hektar, was etwa 13 Prozent der Gesamtwaldfläche in Vorarlberg entspricht. Zudem verfügen die Projekte über eine Laufzeit von 30 Jahren und sollen so zum Erhalt des Waldes beitragen.

Projekte werden jährlich validiert

Künftig sollen die Projekte jedes Jahr von externer, unabhängiger Stelle – in Österreich vom TÜV Austria – validiert, und die Menge der CO2-Gutschriften nach Verifizierung zertifiziert werden. Neben Österreich arbeitet Tree.ly aktuell an weiteren Projekten in Deutschland, Italien, den Niederlanden und in Tschechien.

“Wir bilden den Wald digital ab, begleiten den gesamten Zertifizierungsprozess bis zur Validierung mit jährlichem Monitoring durch den TÜV Austria und übernehmen Marketing sowie Vertrieb der verifizierten Klimaschutzleistungen für einen nachhaltigen Beitrag zum globalen Klimaschutz”, so Batlogg von Tree.ly. Unternehmen und Privatpersonen haben übrigens ab sofort die Möglichkeit, diese Gutschriften direkt von Tree.ly und ihren Vertriebspartner:innen zu erwerben.