✨ AI Kontextualisierung

Das Team des Linzer Startups NXAI rund um KI-Pionier und JKU-Linz-Professor Sepp Hochreiter, der als Chief Scientist fungiert, und CEO Albert Ortig hat es bereits gezeigt: Auf seine Ansagen folgen auch entsprechende Ergebnisse. Im Mai dieses Jahrs veröffentlichte das Unternehmen wenige Monate nach seiner Gründung sein erstes Large Language Model (LLM). Nun folgte, wie bereits im August angekündigt, die nächste Version: das “xLSTM 7B Modell”.

xLSTM 7B deutlich kleiner als die LLMs der großen Player

Wer nun einen österreichischen ChatGPT-Konkurrenten erwartet, wird allerdings enttäuscht. Das NXAI-Modell richtet sich nämlich nicht an die breite Öffentlichkeit und weist deutliche Unterschiede zu den Modellen der großen Player auf. Mit sieben Milliarden Parametern (7B), auf deren Basis es trainiert wurde, ist es maßgeblich kleiner als die bekannten Modelle – GPT-3 von OpenAI wurde etwa mit 175 Milliarden Parametern trainiert, bei GPT-4 wurde die genaue Zahl nicht kommuniziert.

NXAI setzt auf andere Architektur

Im Unterschied zu den großen Playern soll jedoch auch die Stärke von xLSTM 7B liegen. Aufbauend auf der von Sepp Hochreiter bereits in den 1990er-Jahren mitentwickelten Long Short-Term-Memory-Technologie (LSTM) setzt das Modell auf eine andere Architektur, als die bei den bekannten Modellen genutzte “Transformer”-Technologie.

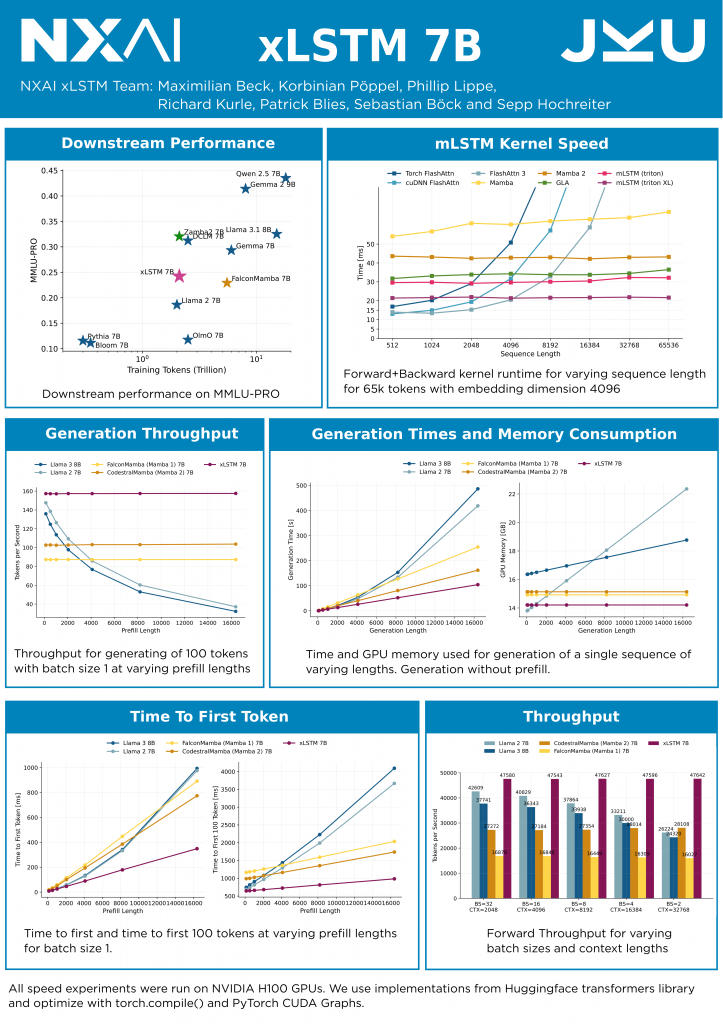

“Im Gegensatz zur Transformer-Technologie steigen die xLSTM-Berechnungen nur linear mit der Textlänge und brauchen im laufenden Betrieb weniger Rechenleistung. Das ist ein großer Vorteil, da komplexe Aufgaben viel mehr Text sowohl zur Aufgabenbeschreibung als auch zur Lösung brauchen”, heißt es dazu von NXAI. xLSTM 7B sei dadurch deutlich effizienter, schneller und brauche weniger Rechenressourcen als andere Large Language Models. Anhand diverser Benchmarks, etwa Massive Multitask Language Understanding (MMLU), vergleicht das Startup sein Modell mit anderen Modellen in ähnlicher Größe (siehe Grafik) und sieht seinen Claim bestätigt.

Hochreiter: “Es ist das energieeffizienteste Modell in der Welt der Large Language Models mit einer schnellen Inferenz”

“Unsere Skalierungsvorhersagen aus unserer Arbeit sind eingetreten. Mit dem xLSTM 7B Modell präsentieren wir das beste Large Language Model (LLM), das auf rekurrenten neuronalen Netzen (RNNs) basiert. Es ist das energieeffizienteste Modell in der Welt der Large Language Models mit einer schnellen Inferenz”, kommentiert Hochreiter.

Zielgruppe für NXAI vor allem Industrie und Robotik

NXAI richtet das Modell klar auf den B2B-Bereich und hier primär auf den Industrie-Sektor aus. “Ich sehe großes Potenzial für xLSTM in der Robotik, weil es in der Inferenz deutlich schneller und speichereffizienter ist”, meint Hochreiter. Seit der Erstveröffentlichung der Architektur im Frühjahr hätten bereits viele Entwickler:innen Lösungen auf deren Basis vorgestellt. “Besonders KI-Anwendungen im Edge- und Embedded-Bereich profitieren enorm von der hohen Effizienz und Geschwindigkeit unseres Modells. Jeder Forscher weltweit kann das xLSTM 7B Modell für seine Arbeit nutzen. Es ist ein Modell aus Europa für die Welt“, so Hochreiter.