✨ AI Kontextualisierung

Vegetarische Wurst aus Soja, Rad fahren bei Kälte und Schneeregen, biologisch abbaubare Babywindeln – die Erde ist unser Lieblingsplanet, und um ihn zu schützen, haben wir uns so einiges einfallen lassen. Es schläft sich dann besser. Mit dem guten Gefühl, sich für den Umweltschutz eingesetzt zu haben, können wir gemütlich den Laptop zur Hand nehmen und eine Doku über Klimaschutz oder Atommüll streamen. Wir können uns mit unseren Freunden über soziale Netzwerke dazu verabreden, uns an Bäume zu ketten, oder auf Amazon nach Biokokosöl suchen.

Dass wir bei all diesen Aktivitäten den Natur- und Umweltschutz dann doch vernachlässigen, daran haben wir bisher kaum gedacht. Den Preis der Digitalisierung haben wir nicht auf Klimawandel und Naturschutz umgerechnet. Und die Vorstellung ist auch irgendwie abstrakt: Die enorme Menge an Daten, die täglich durch das Web geschickt wird, muss irgendwo verarbeitet und gespeichert werden – das ist für die Umwelt in vielerlei Hinsicht eine Herausforderung.

+++ Nachhaltig durchstarten: 4 Anlaufstellen für Green Startups in Österreich +++

Datenzentren als Stromfresser

Da ist zunächst einmal die Frage der Stromversorgung. Bis zu zwölf Prozent der weltweit erzeugten Elektrizität sollen laut Studien vom IT-Sektor verbraucht werden. Das liegt zum einen daran, dass Technologiekonzerne zur Fertigung der Endgeräte immer mehr Energie benötigen. Auf der anderen Seite produzieren digitale Innovationen wie Streamingdienste, Cloud-Computing oder das Internet of Things riesige Mengen an Daten. Im Jahr 2003 existierten weltweit fünf Exabyte an digitalen Inhalten, das entspricht fünf Trilliarden Gigabyte. Bis 2019 sollen jährlich 10,475 Exabyte dazukommen. Um dieses Datenaufkommen stemmen zu können, bleibt IT-Konzernen nichts anderes übrig, als immer neue Datenzentren zu errichten. Dort müssen unzählige Servertürme betrieben und gekühlt werden. Man könnte auch sagen, diese Datenzentren sind sehr hungrig – hungrig nach Strom.

Schmutzige Energiequellen

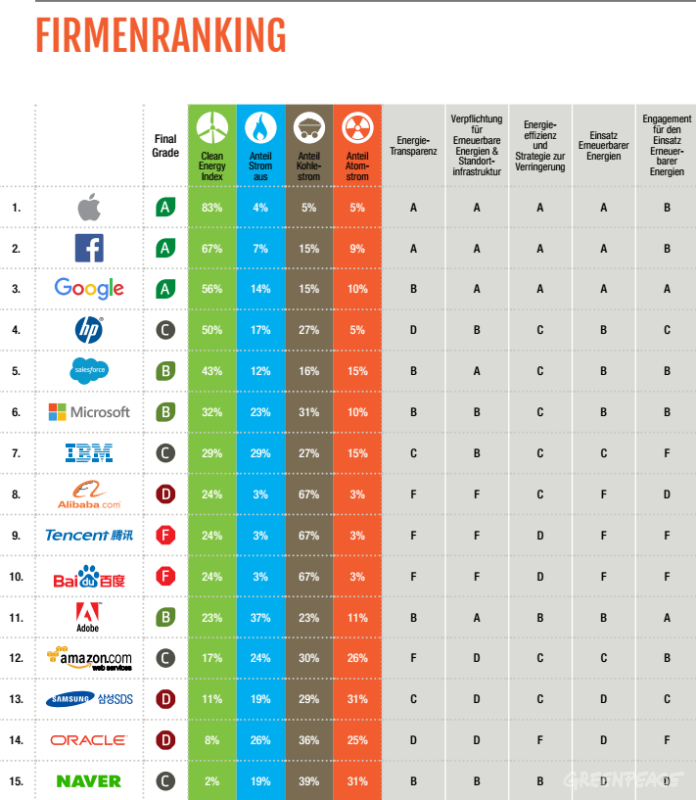

Wie problematisch sich das massive Datenaufkommen auf Klima und Natur auswirkt, ist laut der Umweltschutzorganisation Greenpeace hauptsächlich davon abhängig, woher der benötigte Strom kommt. Seit 2009 kategorisiert Greenpeace in seinem Clicking-Clean-Report IT-Konzerne nach Schulnotensystem. Als „Klassenbeste“ schneiden dabei Apple, Facebook und Google ab. Alle drei beziehen den Großteil ihrer benötigten Elektrizität aus sogenannten „sauberen“ Quellen und haben es sich vor fünf Jahren zum Ziel gesetzt, ihren Strom zukünftig zu 100 Prozent aus erneuerbaren Quellen zu beziehen – allerdings ohne bindenden Zeitrahmen. Bei Apple und Google soll die Versorgung mit regenerativer Energie derzeit parallel zum Unternehmenswachstum ansteigen.

Ganz hinten im Ranking liegen die asiatischen IT-Riesen Tencent und Baidu. Beide decken ihren Energiebedarf zu 67 Prozent mit Strom aus Kohlekraftwerken. Auch der Cloud-Computing-Marktführer Amazon Web Services (AWS) landete in den vergangenen Jahren nicht auf den Topplätzen des Rankings. Seit 2016 soll er laut Greenpeace nun aber entscheidende Schritte in Richtung grüne Energieversorgung unternommen haben. Allerdings kritisiert die Umweltorganisation nach wie vor die mangelnde Transparenz des Unternehmens hinsichtlich seiner Energiepolitik. Unter allen Cloud-Providern ist AWS der einzige, der sich weigert, detaillierte Informationen über seinen ökologischen Fußabdruck zu veröffentlichen.

Redaktionstipps

Streaming als Herausforderung

Sehr schlecht schneiden laut Greenpeace Streaming- Plattformen ab, wenn es um die Energieversorgung geht. Und das, obwohl Videostreaming einer der größten Treiber der Datennachfrage ist. 2015 machte es 63 Prozent des weltweiten Internetverkehrs aus. Bis 2020 soll es die 80-Prozent-Marke erreichen. In Nordamerika ist alleine Netflix für mehr als ein Drittel des gesamten Internetverkehrs verantwortlich. Unter den neun von Greenpeace untersuchten Plattformen erhielten vier die Bewertung „Nicht genügend“. Weitere drei, darunter auch Vimeo, bekamen einen Vierer. Einzig die Google-Tochter Youtube wurde mit 56 Prozent sauberer Energieversorgung mit „Sehr gut“ bewertet.

Eine Frage der Politik

Nicht zuletzt ist auch ein politischer Faktor mit einzuberechnen, wenn es um die Energieversorgung der großen Technologiekonzerne geht. Vor allem im asiatischen Raum behindern Monopolstellungen am Elektrizitätsmarkt den Zugang zu erneuerbaren Energieformen. “Wenn es hier zu keiner politischen Veränderung kommt, wird das schnelle Wachstum des Internets in Ostasien vor allem durch Energie aus Kohle und anderen ‘schmutzigen’ Quellen vorangetrieben werden”, heißt es seitens Greenpeace. Aber auch in den USA könnte es unter Donald Trump zu energiepolitisch fragwürdigen Entscheidungen kommen. Der US-Präsident hat schließlich mehrfach angekündigt, die Klimapolitik einzuschränken und die Elektrizität wieder vermehrt aus Kohlekraftwerken beziehen zu wollen. Das ist das genaue Gegenteil von dem, was Obama zuvor mit seinem Clean Power Plan erreichen wollte. Umweltschützer sehen bei der Wiederbelebung der Kohleindustrie vor allem deshalb eine große Bedrohung, da im Raum Virginia derzeit besonders viele neue Datenzentren entstehen, die oft keine erneuerbaren Energien nutzen.

Entsorgungsprobleme bei Elektroschrott

Der hohe Energiebedarf der Datenzentren ist aber nicht der einzige negative Effekt der Digitalisierung auf die Umwelt. Bisher nur unzureichend geklärt ist nämlich auch die Frage der Entsorgung von Elektroschrott. Die Maschinen und Apparate, die ein Rechenzentrum benötigt, haben nur eine begrenzte Lebensdauer. So muss ein Server beispielsweise alle drei bis fünf Jahre ausgetauscht werden. Auch im Privatgebrauch fällt immer mehr schwer recycelbarer Elektromüll an. Das liegt nicht nur daran, dass wir mehr und mehr Geräte besitzen, sondern auch daran, dass wir sie austauschen, lang bevor sie nicht mehr funktionieren – einfach, weil sie aus der Mode gekommen sind.

Ein großer Teil dieser Abfälle wird aus den USA und Europa nach Afrika gebracht und dort auf Feldern verbrannt. Bei diesem Prozess werden chemische Bestandteile der Geräte freigesetzt. Diese sind nicht nur für die verantwortlichen Arbeiter, sondern auch für die Umwelt extrem schädlich. Die giftige Asche wird durch den Wind verteilt und gerät so beispielsweise in das Trinkwasser von Tieren. Die Digitalisierung an sich ist deshalb nicht böse. Das Argument „Wir haben jetzt Videokonferenzen und müssen daher nicht mehr so viel reisen“ hat durchaus seine Berechtigung. Trotzdem, man sagt: „Es ist nicht alles Gold, was glänzt.“ Und so ist es – denn manchmal glänzt nur der Elektroschrott in der afrikanischen Sonne.

+++ 5 österreichische Green-Tech-Startups, die man kennen sollte +++