✨ AI Kontextualisierung

Für die Studie „After the Honeymoon Ends: Making Corporate-Startup Relationships Work“ befragte die Boston Consulting Group (BCG) insgesamt 190 große Unternehmen und 90 Startups im gesamten DACH-Raum. Insgesamt 570 Unternehmen wurden zudem auf den Einsatz von Corporate-Startup-Collaboration-Vehikeln gescreent. Das wohl herausstechendste Ergebnis der Befragung für den Gesamtraum: Weniger als die Hälfte der befragten Startups (45 Prozent) ist mit den durchgeführten Projekten zufrieden. Bei den befragten Corporates sind es immerhin 55 Prozent.

+++ Fokus: Corporate Innovation +++

Zu lange Entscheidungsprozesse als größter Painpoint für Startups

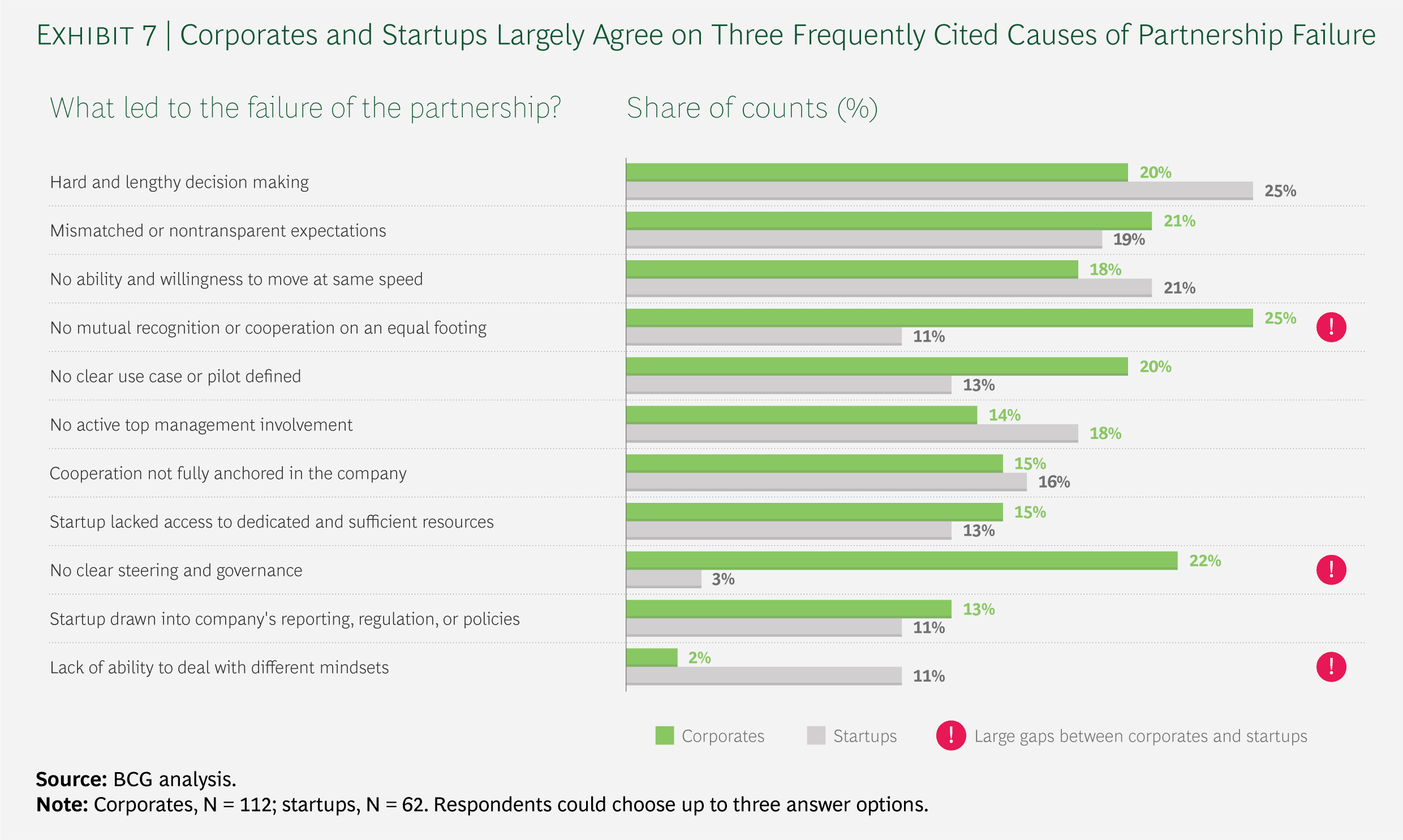

BCG fragte auch nach den Gründen für das Scheitern von Collaboration-Projekten (siehe Grafik). Auf Startup-Seite nehmen zu lange Entscheidungsprozesse (wenig überraschend) den Negativ-Spitzenplatz ein. Sie wurden von 25 Prozent der Befragten genannt (im Gegensatz zu 20 Prozent bei den befragten Corporate-Vertretern). Auf Seiten der Großunternehmen wiederum wird das Fehlen gegenseitiger Anerkennung bzw. das „nicht auf Augenhöhe“ Zusammenarbeiten mit 25 Prozent Zustimmung als größter Painpoint identifiziert – das sehen hingegen nur 11 Prozent der befragten Startup-Gründer als eines der größten Probleme.

Gaps in der Problem-Wahrnehmung

Noch größere Gaps in der Problem-Wahrnehmung gibt es beim Punkt „keine klare Steuerung und Governance“, der von 22 Prozent der Corporates, aber nur von 3 Prozent der Startups als Grund fürs Scheitern gesehen wird, und umgekehrt bei „mangelnde Fähigkeit, mit unterschiedlichen Mindsets umzugehen“, die 11 Prozent der Startups, aber nur 2 Prozent der Großunternehmen als massives Problem sehen. Relativ einig sind sich Corporates und Jungunternehmen bei der Problemquelle „unangemessene oder intransparente Erwartungen“ (Corporates: 21 Prozent; Startups: 19 Prozent).

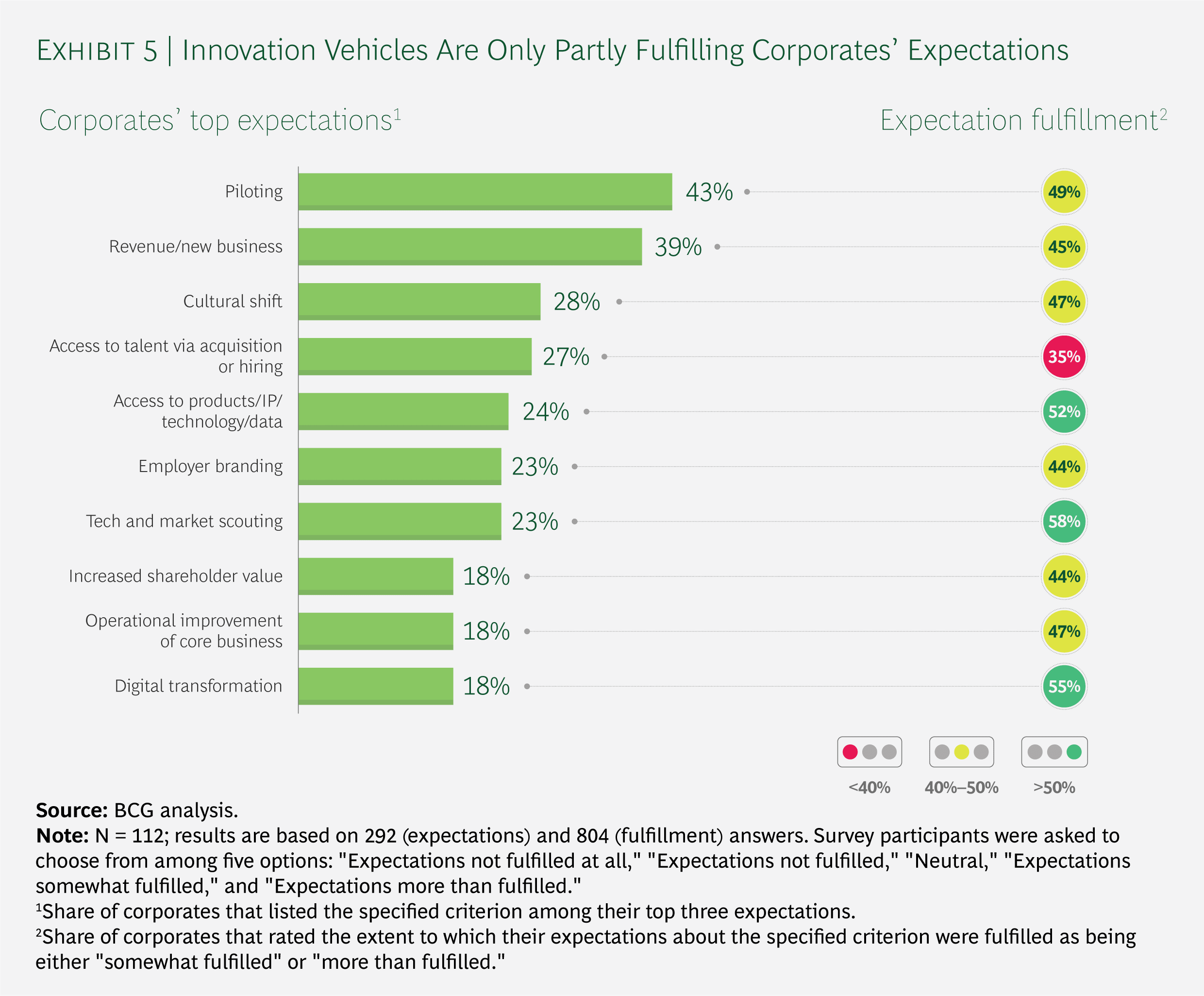

Corporates: Große Erwartungen in Pilotierung und neue Umsatzquellen

Nach eben diesen Erwartungen und deren Erfüllung fragte BCG in einem weiteren Fragenblock. Demnach wünschen sich Großunternehmen in der Corporate-Startup-Collaboration vor allem Pilotprojekte (von 43 Prozent der Befragten genannt) und neue Umsatzquellen (39 Prozent). Auch eine Änderung der Unternehmenskultur (28 Prozent) und der Zugang zu Talenten (27 Prozent) stehen hoch im Kurs. Diesen letzten Punkt sehen aber nur 35 Prozent der befragten Corporates erfüllt. Besonders zufrieden (58 Prozent) sind sie dagegen mit der Erfüllung der Erwartung, neue Technologien und Märkte zu scouten. Generell bewegen sich die Quoten bei der Erfüllung von Erwartungen um die 50 Prozent (siehe Grafik).

Startups: Viele Erwartungen kaum erfüllt

Anders sieht es bei den befragten Startups aus. Zwar sind die drei wichtigsten Erwartungen, Umsatzsteigerung durch neue Absatzmöglichkeiten (von 73 Prozent der Befragten genannt), Umsatzsteigerung durch Marktzugang (60 Prozent) und neue Referenzen und gesteigerte Reputation (50 Prozent) recht gut erfüllt (siehe Grafik). Andere Punkte sehen die befragten Startups dagegen kaum umgesetzt, etwa den Erwerb technischen Know-hows (13 Prozent), den Zugang zu IP und Daten (16 Prozent) oder den Zugang zu Kapital (17 Prozent).

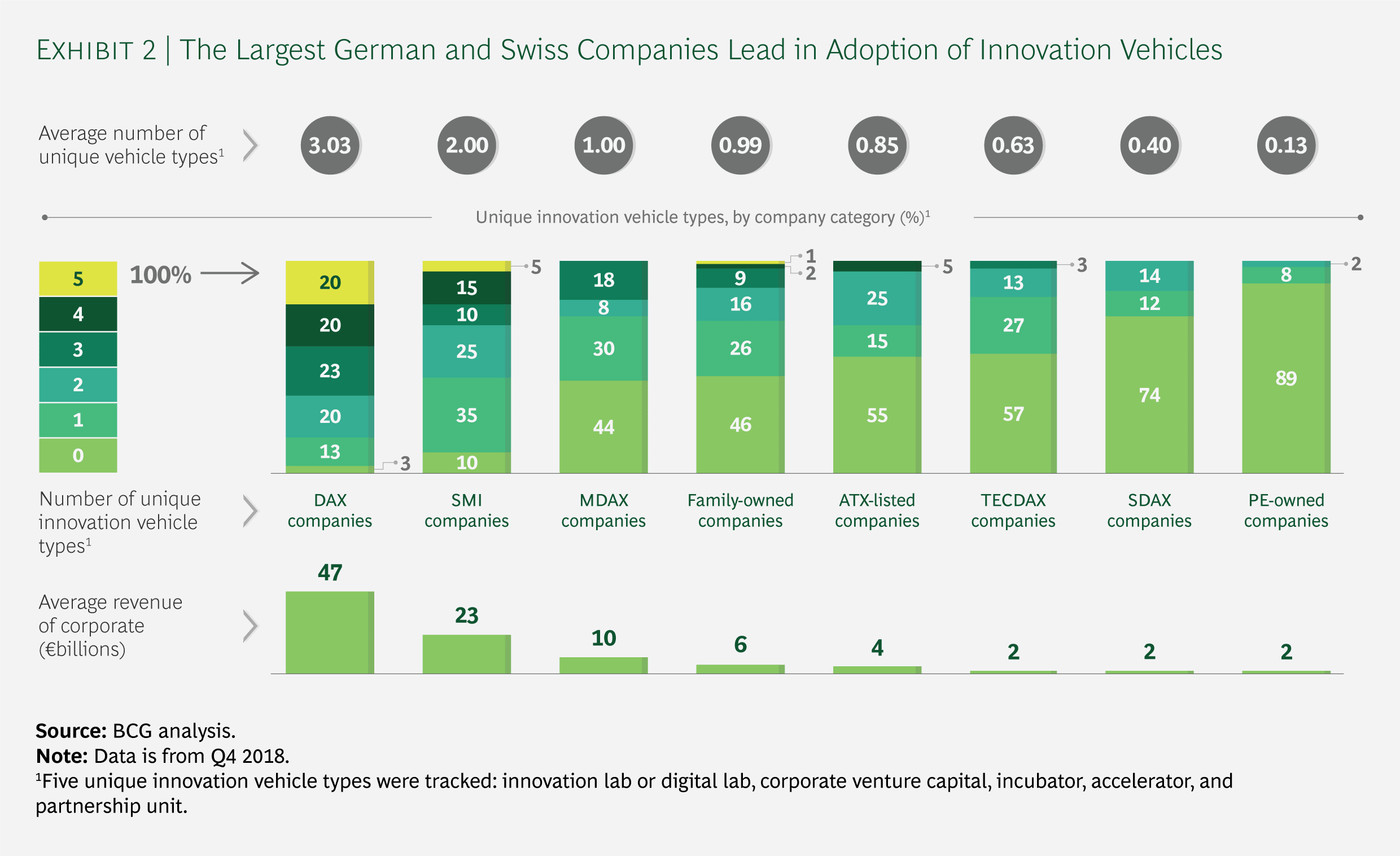

ATX-Konzerne hinken bei Corporate-Startup-Collaboration hinterher

Im Rahmen der BCG-Studie wurden auch die Startup-Aktivitäten der Großunternehmen in Deutschland, der Schweiz und Österreich verglichen. Fünf Kategorien wurden dafür definiert: Digital- bzw. Innovationslabs, Corporate Venture Capital, Inkubatoren, Accelerators und Kooperations-Units. Dabei zeigt sich, dass österreichische börsennotierte Unternehmen im Vergleich deutlich hinterherhinken. Gerade neun von 20 ATX-Unternehmen nutzen überhaupt eine der genannten Kooperationsformen. Bei den DAX-Konzernen sind es dagegen 29 von 30, im Schweizer Leitindex SMI 18 von 20.

Heimische Familienunternehmen im Vergleich offener

Auch wenn es um die Anwendung mehrerer der genannten Vehikel geht, zeigt sich ein massiver Unterschied zwischen ATX- und DAX- bzw. SMI-Unternehmen. Während sechs DAX-Konzerne und immerhin ein SMI-Konzern alle fünf Kooperationsformen nutzt, kommt der in diesem Bereich stärkste ATX-Konzern, UNIQA, auf vier Vehikel-Arten (siehe Grafik). Im Vergleich zum DACH-Durchschnitt offener für Startup-Kooperationen zeigen sich dafür allerdings heimische Familienunternehmen. Immerhin 60 Prozent nutzen hierzulande zumindest eine der Kooperationsformen.