✨ AI Kontextualisierung

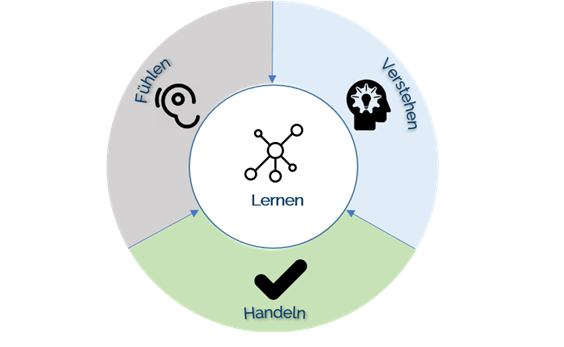

Im ersten Artikel haben wir „Künstliche Intelligenz (KI)“ als die Fähigkeit einer Maschine beschrieben, aus eigener Erfahrung zu lernen und sich anzupassen. In diesem Artikel wollen wir tiefer in die Materie eintauchen. KI besteht aus vielfältigen Technologien, die das Ergebnis einer Kombination aus drei Elementen ist: Verstehen, Fühlen und Handeln.

+++ Teil 1 der Serie: Wirtschaftswachstum durch Künstliche Intelligenzen +++

Verstehen: Den Input verarbeiten und sinnvoll antworten

Beim Verstehen stehen Sprachverarbeitung und Wissensrepräsentation im Vordergrund. Umgesetzt auf Menschen geht es also um die typische Kette: Zuhören (oder Lesen) – Verarbeiten – sinnvoll Antworten. Natural Language Processing (NLP) kombiniert Technologien, die in der Lage sind, Sprache in gesprochener oder schriftlicher Form zu verstehen und zu generieren. Wissensrepräsentation hilft dabei, Wissen zu kommunizieren und die anschließende Entscheidungsfindung zu erleichtern, wie es beispielsweise bei digitalen Assistenten der Fall ist. So arbeitet etwa ein Team ehemaliger FH-Hagenberg Studenten mit myAlfred an einem digitalen Butler. Der Assistent soll Termine organisieren, Reisen buchen, Tische reservieren und vieles mehr.

Fühlen: Gesehenes, Gehörtes und Gespürtes verarbeiten

Das Fühlen beinhaltet maschinelles Sehen, Spracherkennung und die Weiterverarbeitung in Sensoren. Dadurch ist es möglich, die Eingabeinformationen von Kameras, Mikrofonen oder anderen Sensoren zu erfassen, zu identifizieren, zu analysieren und zu verarbeiten. Angewendet wird die Technologie in den unterschiedlichsten Industrien. Das niederösterreichische Unternehmen Peschak Autonome Systeme hat sich etwa auf die Landwirtschaft spezialisiert und rüstet Traktoren zu selbstfahrenden Maschinen um. Das System nutzt Stereokameras, um ein präzises dreidimensionales Bild der Umgebung zu schaffen und kann so auf seine Umwelt reagieren.

Handeln: Das Verstandene und Gefühlte umsetzen

Nachdem Informationen durch Verstehen und Fühlen gesammelt sind, ist der logische dritte Schritt das Handeln. Das kommt vor allem in der industriellen Robotik zum Einsatz, wie Amazons Lagerhallen eindrucksvoll zeigen. Auch für heimische Unternehmen könnte das enormes Potential haben, man denke nur an die riesigen Lagerflächen großer Supermarktketten.

Was brauchen Maschinen, um „menschlich“ zu handeln?

Verständnis, Sensorik und Verarbeitung, also Verstehen, Fühlen und Handel, sind die drei Säulen der Künstlichen Intelligenz. Stuart Russell und Peter Norvig beschreiben in ihrem 2009 erschienen Buch „Artificial Intelligence: A Modern Approach“ welche konkreten Fähigkeiten Maschinen besitzen müssen, um wie Menschen handeln zu können:

- Natürliche Sprachverarbeitung

- Einen Speicher für die vor oder während des Gesprächs bereitgestellten Informationen

- Automatisierte Argumentation

- Machine Learning, um sich an neue Umstände anzupassen und Muster abzuleiten

Wenn Maschinen nicht mehr von Menschen zu unterscheiden sind

Bekannt ist in diesem Zusammenhang der 1950 entwickelte Turing-Test. Das Testverfahren besteht zusammengefasst darin, dass sich ein menschlicher Fragesteller mit zwei ihm unbekannten Gesprächspartnern unterhält. Der eine Gesprächspartner ist ein Mensch, der andere eine Maschine. Wenn der Fragesteller trotz intensiver Befragung nicht klar sagen kann, welcher von beiden die Maschine ist, hat die Maschine den Turing-Test bestanden. Bis jetzt hat es kein Computer geschafft, die Fragenden zu überzeugen. Einzig das russische Programm Eugene Goostman konnte 2014 rund ein Drittel aller Tester täuschen, allerdings bediente es sich einiger Tricks, wie etwa der Angabe, dass Englisch nicht die Muttersprache sei und man deshalb Verständigungsprobleme hätte.

Eingeschränkte KI: Der Schachcomputer kann keine Pizza bestellen

Der Turing-Test ist nun schon über ein halbes Jahrhundert alt und trotzdem stehen wir erst am Anfang der Entwicklung. Artificial Narrow Intelligence oder auf Deutsch „eingeschränkte künstliche Intelligenz“ beschreibt, was heute technisch möglich ist. Maschinen können sehr gut ein definiertes Set an Aufgaben lösen. Der Schachcomputer schafft es, Millionen von komplexen Zügen vorauszuberechnen, aber er kann keine Pizza bestellen.

Redaktionstipps

Mit einer Größe von drei Tennisfeldern dem Menschen ebenbürtig

Nur Maschinen mit riesiger Rechenkapazität können verschiedenste Situationen intellektuell verarbeiten, womit Artificial General Intelligence (AGI) umschrieben ist. Einige bemerkenswerte Projekte in diesem Bereich existieren bereits, wie etwa der chinesische Supercomputer „Tianhe-2“. Dieser Computer hat theoretisch die Rechenleistung, um dem intellektuellen Verständnis eines Menschen nahezukommen. Mit einer Grundfläche von fast drei Tennisfeldern ist Tianhe-2 aber nicht gerade fürs Home-Office geeignet. AGI bleibt daher vorerst großen Forschungsprojekten vorbehalten.

Mit Qubits zur Überlegenheit

Allerdings zeigte schon die Smartphone-Entwicklung, wie schnell immer bessere Rechenleistung in kleinere Geräte verbaut wurde. Mehr Rechenleistung wird wiederum die Entwicklung von entsprechender Software vorantreiben, bis vielleicht sogar Artificial Superintelligence (ASI) möglich wird. ASI wäre ein Computer, dessen Intelligenz die des Menschen überschreitet. In diesem Zusammenhang ist auch Quantum Computing ein wichtiger Begriff. Während Computer mit Bits – also Nullen und Einsen arbeiten – nutzen Quantencomputer sogenannte Qubits, die mehrere Zustände einnehmen können und dadurch enorme Rechenleistungen erlauben.

Viele Meilensteine zurück – noch mehr voran

„Künstliche Intelligenz“ wurde erstmals zum Thema auf der Darmouth Conference, die 1956 vom Informatiker John McCarthy organisiert wurde. Nach der Konferenz gab es die ersten Systeme, die als „allgemeine Problemlöser“ bezeichnet werden können. Im Jahr 1985 entwickelte der Psychologe Frank Rosenblatt mit „perceptron“ das erste neurale Netzwerk. Die 80er-Jahre brachten dann den Aufstieg des Deep Learnings, als Pionier Geoffrey Hinton einen Weg fand, um neurale Netzwerke zu trainieren und Fehler zu korrigieren. 1996 schlug IBMs Supercomputer „Deep Blue“ den amtierenden Schachweltmeister Garri Kasparow.

Im Jahre 2007 gründete Li Fei-Fei, Professorin an der Standford University, mit ImageNet eine kostenfreie Online-Datenbank mit mehr als 14 Millionen verschlagworteten Bildern, die als Grundlage für neurale Netze dient. Im Jahre 2012 hörte man erneut von KI und Deep Learning, als Google Brain die Ergebnisse von „cat experiment“ veröffentlichte. Ein neurales Netzwerk hat sich selbst so trainiert, dass es Katzen aus 10 Millionen nicht beschrifteten Bildern auf YouTube erkannte.

Alle diese historischen Meilensteine zeigen, welchen langen Weg das Thema künstliche Intelligenz bereits hinter sich hat. Im dritten Teil der Artikelserie werden wir uns mehr der aktuellen KI-Forschung widmen.

+++ Kurioser Usecase: Artificial Intelligence benennt Meerschweinchen +++

Über die Autoren

Dieser Artikel ist Bestandteil einer von Venionaire Capital verfassten vierteiligen Serie über Künstliche Intelligenz für DerBrutkasten.com. Autoren sind Aleksandar Vucicevic (Senior Analyst), Sarah Grandits (Marketing Assistant), Fabian Greiler (Junior Partner) und Berthold Baurek-Karlic (Managing Partner).

Venionaire hat sich auf die Innovationsberatung, Corporate Startup Engagement und dem Management von Venture Capital Fonds für Dritte spezialisiert.

Mit Partnern der KPMG Österreich hat Venionaire zudem das Investorennetzwerk European Super Angels Club gegründet, der in geschäftlichen Beziehungen mit im Text genannten Startups Yodel.io, Grape und oratio steht.