✨ AI Kontextualisierung

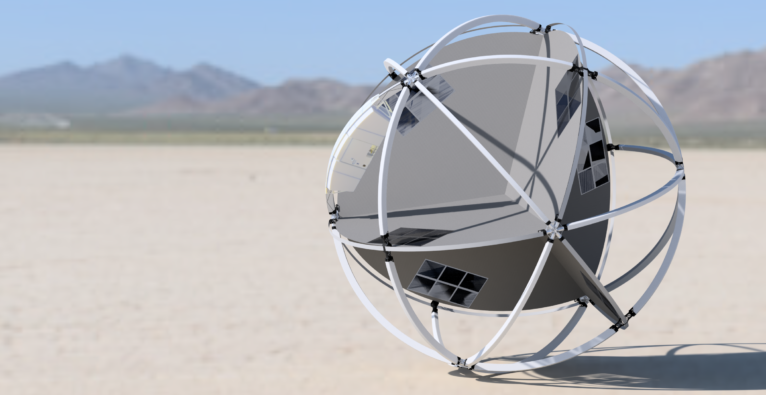

„Völlig losgelöst von der Erde“. Wo Peter Schilling mit seinem Lied tausende Kehlen zum Singen bringt, da möchten Julian Rothenbuchner, Moritz Stephan und Nicola Weiroster mit ihrem Startup Tumbleweed einen anderen Zugang zum Weltall etablieren. Genauer gesagt planen die drei Founder für die Nutzung des Mars und dessen Erforschung einen kommerziellen und standardisierten Anstrich zu verpassen – und dabei kostensparend zu agieren. „From a garage in Vienna to the Red Planet“ steht auf der Webseite des Unternehmens. Angefangen hat alles jedoch während einer öden Zeichenstunde.

+++ Elon Musk: Stadt am Mars benötigt 1000 Raumschiffe und 20 Jahre +++

Tumbleweed nutzt Windgeschwindigkeit des Mars

„Wir waren schon immer interessiert am Weltraum. Julians und Moritz damaliger Physiklehrer hat beide dann auf den ‚Odysseus Space Contest‚ aufmerksam gemacht. Der Gewinner im letzten Jahr war ein Rover. Das hat die Idee initialisiert. Wir wollten aber keinen herkömmliches Mars-Gefährt bauen, sondern einen anderen, effizienteren, simpleren Ansatz wählen. Während einer langweiligen BE-Stunde haben wir dann einige Papers gelesen, in denen die enormen Windstärken (Anm.: bis zu 360 km/h) auf dem Mars untersucht wurden. Da wurde direkt die Idee geboren diese zu nutzen.“, erklärt Mitgründer Weiroster.

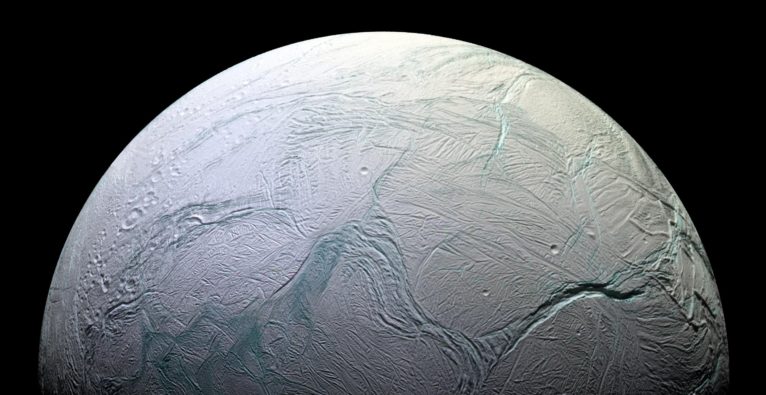

In 20 Tagen den halben Pol am Mars erforschen

Für das Konzept des Tumbleweeds hat das Startup Anleihen an der Natur genommen und sich alter Cowboy-Movies als Stilmittel bedient. Die „Steppenläufer“, wie man sie aus dramatischen Szenen in Western-Filmen kennt, dienen als Design-Vorlage. So sollen große Flächen abgedeckt werden und das bei minimaler Komplexität und Kosten, so die Idee: Die Winde treiben dabei die Tumbleweed „randomly“ in Richtung des Mars-Äquators , während diese Daten sammeln. Dabei können die einzelnen Maschinen für jede Mission individuell konfiguriert werden und so für eine kostenarme Lösung sorgen. Für rund 50 Prozent Erforschung des Nordpols am Mars soll der Tumbleweed rund 20 Tage brauchen.

Sieg beim Odysseus Space Contest

„Nach der Idee haben wir einen ersten Prototypen gebaut und bei dem ‚Odysseus Space Contest‘ teilgenommen und sowohl auf nationaler als auch auf internationaler Ebene gewonnen. In der Jury waren damals Experten von unzähligen Weltraumorganisationen wie der ESA, ArianeSpace, Airbus, die uns sehr positives Feedback gegeben haben. Das war für uns ein großer Ansporn das Projekt weiter zu verfolgen“ so Weiroster weiter.

Tumbleweed: Weniger spezialisiert und breiter nutzbar

Zwischen herkömmlichen Rovern und Tumbleweed herrscht eine komplett andere Designphilosophie. Konventionelle Rover, wie unter anderem „Curiosity“, sind teure und hoch spezialisierte Unikate. Der Tumbleweed soll in größeren Stückzahlen produziert werden und ein standardisiertes Interface für Forschungsinstrumente bieten.

Vier Flächen für ein Optimum an Windnutzung

Die „tetrahedrally“ (vierflächig) angeordneten Segel sollen für eine optimale Windnutzung sorgen und eine maximale Areal-Abdeckung ermöglichen. In mehr als 100 Simulationen in einem virtuellen Windtunnel wurde ein Strömungswiderstandskoeffizient festgestellt, der um 103 Prozent höher ist, als vergleichbare Daten eines NASA-Tumbleweeds aus dem Jahre 2004.

Curiosity als Punktmessungs-Gerät statt Schwarmforschung

Zudem werden der Tumbleweed und „Curiosity“ für andere Use Cases verwendet. Der Rover des Startups ermöglicht eine schnelle, großflächige Exploration der Marslandschaft, sowie ein Schwarmforschungs-Konzept. „Curiosity kann sich indes im Vergleich nur sehr langsam bewegen, die Daten sind beinahe Punktmessungen“, erklärt der Erfinder.

Solarzellen und Lithium-Batterie

Die sechs Segel des „österreichischen Rovers“ wurden zudem mit je sechs Reihen kristallinen Solarzellen bestückt. Das soll ausreichend Elektrizität erzeugen, um die gesamte Elektronik am Laufen zu halten und eine Lithium-Batterie für Nacht-Missionen anzutreiben.

Eigener Fallschirm inkludiert

Weiters, so Weiroster, zeichnet sich der Tumbleweed durch seine niedrige Komplexität aus. Mit weniger beweglichen Teilen sollen Kosten und Risiko gesenkt werden. Während der EDL-Phase (Entry, Descent, Landing) ist der Tumbleweed sein eigener Fallschirm und muss nicht mit hochkomplexen und riskanten Manövern gelandet werden.

Tumbleweed: 20 statt 1000 Kilogramm

„Ein weiterer wichtiger Aspekt ist das geringe Gewicht. Curiosity wiegt etwa eine Tonne, der Tumbleweed 20 Kilogramm. Im Weltall, wo Gewicht ein starker Treiber ist, können so Missionskosten massiv gesenkt werden. Unsere Vision ist es ‚Deep Space Exploration‘ für einen großen Personenkreis zu eröffnen. Wir sehen uns hier als Enabler für Forscher, denen wir eine standardisierte Plattform bieten, auf der sie ihre Instrumente implementieren können“, sagt Weiroster.

Dafür ist die Kommunikation ein Schlüsselelement. Da der Tumbleweed sich zufällig bewegt, nutzt das Unternehmen omnidirektionale Antennen, um mit Satelliten im Mars-Orbit zu interagieren.

Test in der Negev-Wüste in Israel im Herbst

Aktuell befindet sich das Startup in der finalen Phase den Erd-Prototypen fertig zu stellen. Dieser soll im Oktober 2020 in der Negev Wüste in Israel im Zuge einer Mars-Analog-Mission getestet werden. Parallel dazu wird bereits seit Ende letzten Jahres am nächsten Prototyp gewerkelt, der schon sehr viel näher an einem „space-grade“-Rover herankommen wird.

Launch ist für 2028 geplant

„Nach Zeitplan werden wir 2026 mit der Entwicklung des Rovers fertig sein. Ab da werden wir uns vorrangig mit Themen wie der Integration von ‚Payloads‘, Integration der Rover in der Rakete und ‚Gound Segment‘ beschäftigen.“, sagt Weiroster. „Im Jahr 2028 werden Tumbleweeds dann launchen. Aktuell ist eine Mission mit etwa 100 Stück geplant. Die genaue Zahl kann man jetzt aber noch nicht abschätzen, das ist völlig nachfragegetrieben. Aber natürlich würde auch eine Mission mit weniger Tumbleweeds einen signifikanten Erkenntnisgewinn bedeuten.“

Die Beschaffung jener Erkenntnisse ist jene Maxime, mit der das Startup seine Philosophie antreibt. Besonders hinsichtlich kommerzieller Nutzung des Roten Planeten. Man sieht sich eigener Definition nach als „Enabler“ für Forschung und Industrie.

„Payload Units verkaufen“

„Grundsätzlich werden wir den Platz in den ‚Payload Units‘ verkaufen, ganz analog zum CubeSat-Modell (Anm. Kleinsatelliten). Es gibt unzählige Anwendungsfelder für den Tumbleweed, viele davon sind im Forschungsbereich und zielen darauf ab das Verständnis über den Planeten zu erweitern. Dadurch erhoffen wir uns Erkenntnisse, die möglicherweise den Weg für den ersten Menschen am Mars ebnen“, sagt Weiroster.

Kommerzielle Chancen am Mars

Weiters führt Weiroster aus: „Hinsichtlich der Frage nach kommerziellen Use Cases denken wir, dass die Auffindung von Ressourcen und der Test von Materialien besonders interessant sind. Eine kommerzielle Nutzung ist aber noch etwas entfernt. Heute geht es allein darum, herauszufinden, welche kommerziellen Chancen es überhaupt am Mars gibt“.

Die Partner des Projekts

Unterstützt wird das Startup von Voestalpine Böhler mit finanzieller Zuwendung, aber auch mit Titanteilen aus dem 3D-Druck. Weitere Partner sind die FH Wiener Neustadt, Joanneum und das österreichische Weltraum Forum. Das Highlight jedoch ist seit diesem Jahr die Zusammenarbeit mit der ESA (European Space Agency).

ESA-Inkubator

Das „Business Incubation Programm“ der ESA ist ein zweijähriger Prozess, in dem man neben einer Fördersumme auch Beratungsleistung der Weltraum-Agentur und ihren Partnern bekommt. Dafür hat die supranationale Organisation in jedem ihrer Mitgliedsstaaten Startup-Center eingerichtet, beziehungsweise kooperiert mit Inkubatoren. In Österreich gibt es zwei davon, accent in Wiener Neustadt und SPG in Graz.

„Space Connection“ nötig

„Der Ablauf bei der ESA verhält sich wie bei den meisten Inkubatoren und Förderungen. Zuerst gibt es eine Einreichung mit Businessplan und Pitch. Wichtig ist dabei ein Bezug zum Weltraum, die sogenannte ’space connection‘. Das kann entweder upstream (Entwicklung von Weltraumtechnologie) oder downstream (Weltraumechnologie für Erdanwendungen verwenden) sein“, erklärt Weiroster.

Von Wien bis Palo Alto

Das Studentische Startup hat insgesamt 58 Mitglieder an vier Standorten: Wien, Delft (NL), Palo Alto, Aarhus (DK). Das Team verfügt über unterschiedlichen Kompetenzen. „Die kulturelle Komponente ist hierbei natürlich sehr spannend, man lernt ambitionierte Studenten aus unzähligen Ländern kennen, schließt Freundschaften und lernt voneinander. Der Austausch funktioniert über Videochat – und das war auch schon vor Corona so. Wir haben in Wien gestartet und hier auch dementsprechend das diverseste Team mit einem Großteil der nicht-technischen Gruppen.“, sagt Weinroster. In den Niederlanden sitzen zudem noch Techniker, die an der Rover-Hardware, der Software und Elektronik arbeiten, während sich in Aarhus ein Science-Team mit Anforderungen der Wissenschaft an den Rover beschäftigt.

Silicon Valley und das Weltall

Und auch das Silicon Valley darf in dieser Aufzählung nicht fehlen. Weiroster dazu: „In Palo Alto haben wir auch ein Team aus Software Entwicklern. Und bauen dort Kontakte zur amerikanischen Weltraumindustrie auf.“